强化学习——每次访问MC方法和首次访问MC方法的相关理论证明

前言

本文主要给出每次访问MC方法和首次访问MC方法的相关理论证明,方便大家从根本上去理解这两种方法。

示例——首次访问MC方法和每次访问MC方法的区别

- 首次访问蒙特卡洛策略评估

在给定一个策略,使用一系列完整episode评估某一个状态 时,对于每一个episode,仅当该状态

首次出现的时间

列入计算:

状态出现的次数加1:

总的收获值更新:

状态 的价值:

当 时,

- 每次访问蒙特卡洛策略评估

在给定一个策略,使用一系列完整的episode评估某一个状态 时,对于每一个episode,状态

每次出现在状态转移链时,例如,一次在时刻

,一次在时刻

,则两次对应的

,

都要用于计算

对应的值。

状态出现的次数加1:

总的收获值更新:

状态s的价值:

当 时,

详情请参考:

搬砖的旺财:David Silver 增强学习——Lecture 4 不基于模型的预测

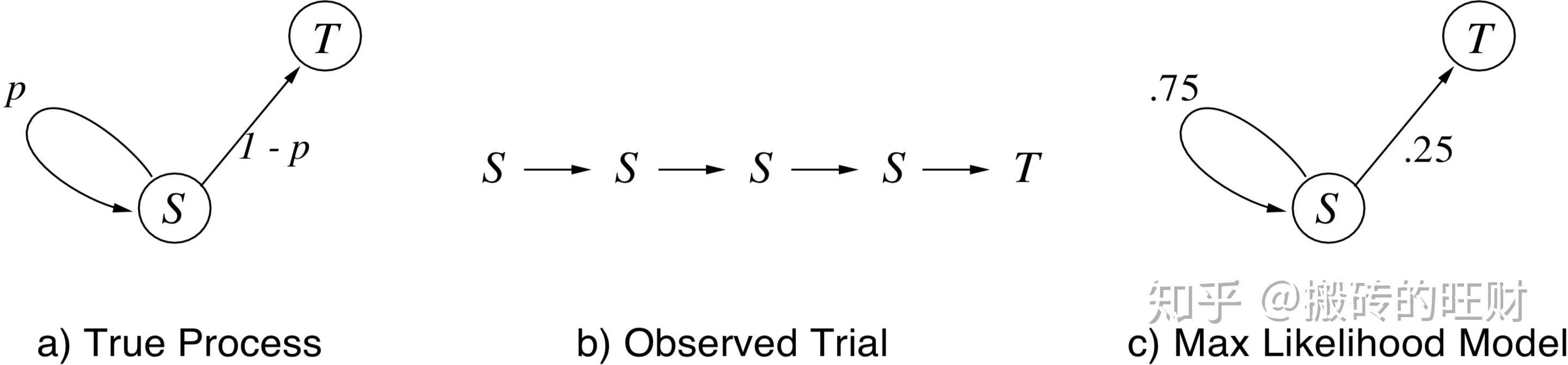

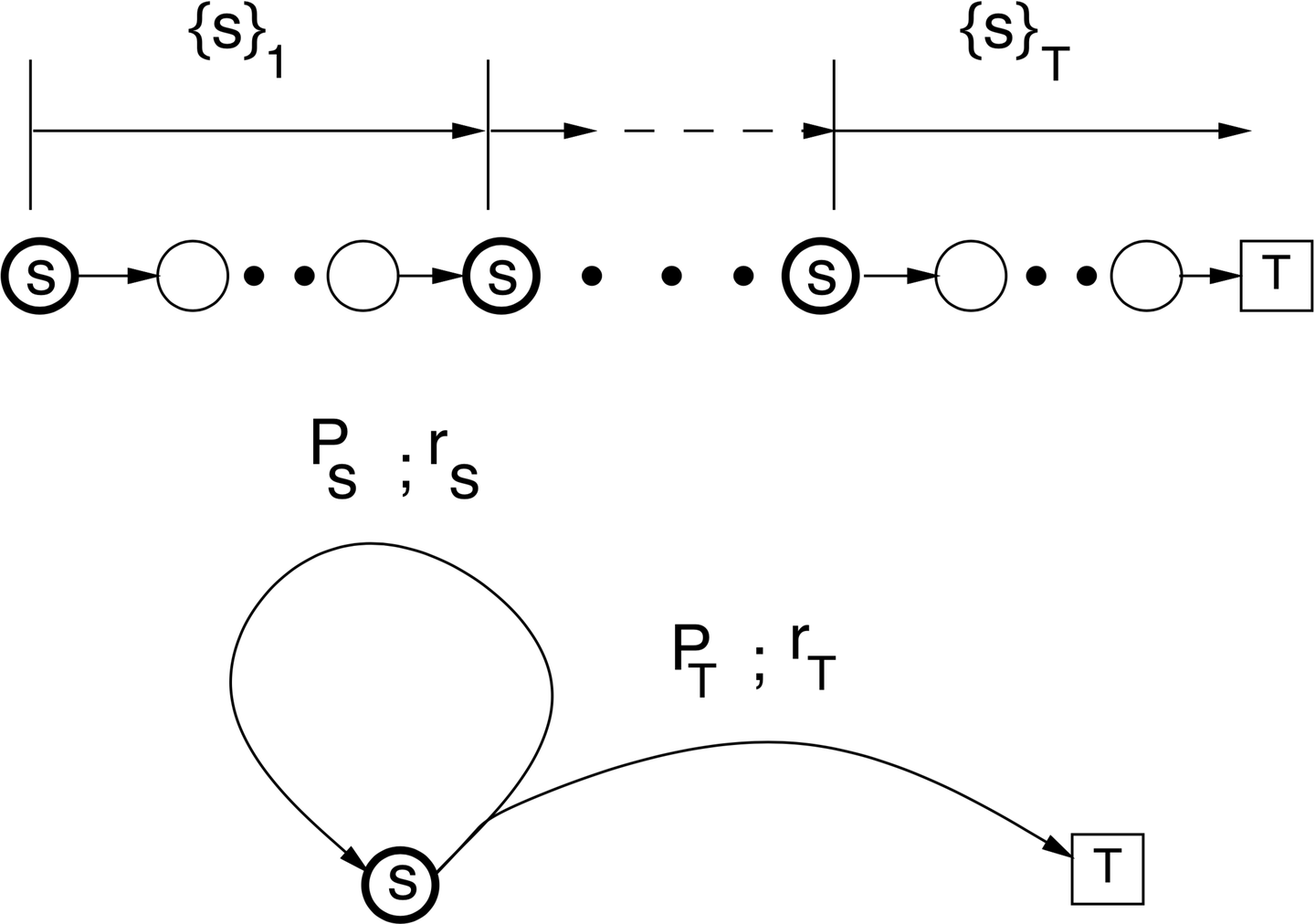

首先考虑图1 a)中所示的马尔可夫链,在每一步中,链或者以概率 保持在

中,或者以概率

前往

结束。假设我们想要估计从状态

开始到终止前的预期步数。考虑从估计值函数入手,那么假设每一步都会得到

的奖励,在这种情况下

等于终止前的预期步数。假设已经观察到的唯一数据是由马尔可夫链产生的单个试验——该试验持续4个步骤,

个从

传递到

,并且

个从

传递到

,如图2 b)所示。那么两个MC方法从这个试验中将会得出什么结论?

我们假设这些方法不知道马尔可夫链的结构。它们所知道的只是图1 b)中所示的试验。

首次访问MC方法(first-visit MC)实际上观察到的是从第一次访问 到

的单次遍历(singel traversal)。该遍历持续

步,因此其对

的估计为

。

另一方面,每次访问MC方法(every-visit MC)实际上观察到的是从 到

的

个单独的遍历,一个有

个步骤,一个有

个步骤,一个有

个步骤,一个有

个步骤。对这四个有效试验进行平均,每次访问MC方法估计的

为

。

哪个估计值更好呢? 还是

呢?我们将在下面说明,实际上

是无偏的答案,

在统计意义上存在偏差。

接下来计算上例的ML估计。如果马尔可夫链的最大似然模型(如图1 c)所示)完全正确,那么在终止之前期望的时间步数是多少呢?对于每个可能的步数 转移概率的最大似然估计(Maximum-Likelihood estimate,ML estimate)是 ,

转移概率的最大似然估计是

。没有观察到其他状态的转移,因此估计它们的概率为

。那么马尔可夫链的最大似然模型如图1 c)所示。

如果马尔可夫过程的最大似然模型完全正确,我们即认为值函数的ML估计是完全正确的。

接下来计算上例的ML估计。如果马尔可夫链的最大似然模型完全正确,那么在终止之前期望的时间步数是多少呢?对于每个可能的步数 ,我们可以计算其发生的概率,然后计算期望:

因此,在该例中,ML估计与首次访问MC方法的估计相同。

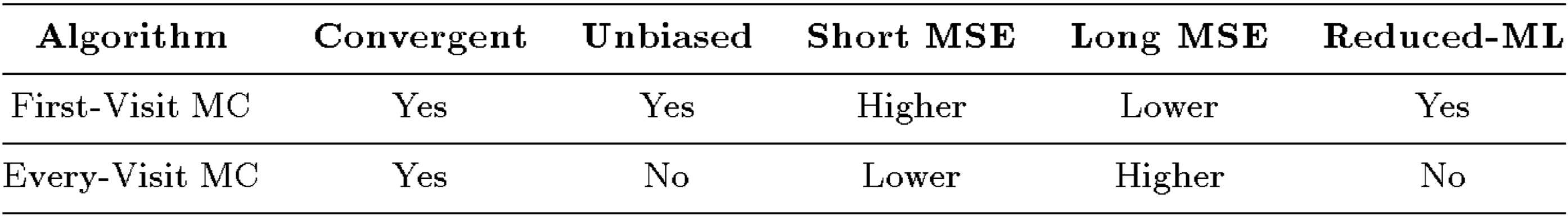

定理1 For any undiscounted absorbing Markov chain, the estimates computed by first-visit MC are the reduced-ML estimates, for all states and after all trials.

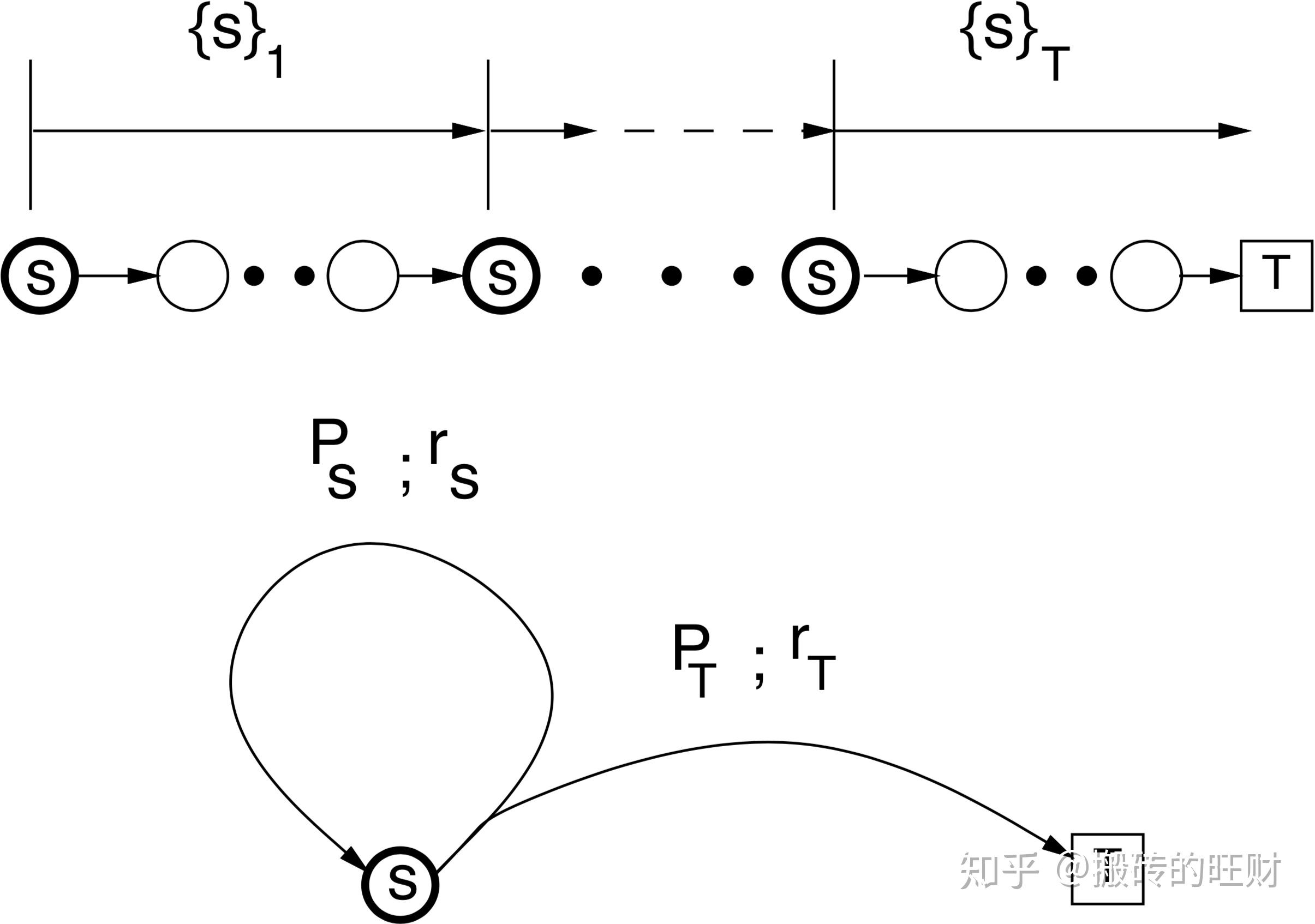

简化的双状态抽象马尔可夫链

在本文中,我们将介绍如何将任意的undiscounted absorbing Markov chain简化为双状态抽象马尔可夫链(two-state abstracted Markov chain),并将它用在MC方法中。简化的依据是独立关注每个状态。假设我们只对一个状态 的价值感兴趣,并且所有的试验都是从状态

开始。我们可以在不失一般性的情况下做到这一点,因为状态

的价值在试验后的变化不受首次访问该状态之前发生的任何事情的影响。

对于任意的马尔可夫链,试验产生两个序列,一个随机的状态序列, ,以

开头并以

结尾,以及相关的随机奖励序列

。将序列

分成连续的子序列,这些子序列以

开头并在下一次重新访问

之前结束。第

次重新访问

开始的子序列表示为

。最后一个这样的子序列是特殊的,因为它以终止状态结束并表示为

。相应的奖励序列类似地表示为

和

。由于马尔可夫性,对于所有的

,

独立于

,类似地

独立于

。这是很有意义的,意味着在访问状态

之间实际发生的精确状态序列在首次访问MC方法(或者每次访问MC方法)估计

时不起作用。同样,精确的奖励顺序

也无关紧要,因为在MC方法中只使用了访问状态

之间的奖励总和。

因此,为了便于分析,可以将任意的undiscounted Markov chain简化为图2下面部分所示的双状态抽象链。

首次访问MC方法 first-visit MC

设 代表成对的随机序列

。

首次访问MC方法通过 次试验后得到的序列

估计的

是

。

其中 是随机数,代表第

次重新访问状态

,

是序列

中各个奖励的总和,

是最后一次访问状态

后收到的总的随机奖励。

对于所有的 ,

。

首次访问MC方法通过 次试验后得到的序列

估计的

是

。

从字面上的意思来理解, 只是来自

个样本

估计的平均值,由于马尔可夫性,样本是独立的。

每次访问MC方法 every-visit MC

每次访问MC方法通过 次试验得到的序列

估计的

值为

。

其中 是随机数,代表第

次重新访问状态

。每次重新访问

都有效地开始了另一次试验(如图1所示)。因此,在第

次和第

次访问状态

之间发生的奖励在估计时被包括了

次。每次访问MC通过

次试验后得到的序列

估计的

是

。

其中 是第

次试验

中状态

的重访次数。与首次访问MC方法的估计器不同,

次试验的每次访问MC方法的估计器不仅仅是单个试验估计值的平均,这使得它的分析更加复杂。

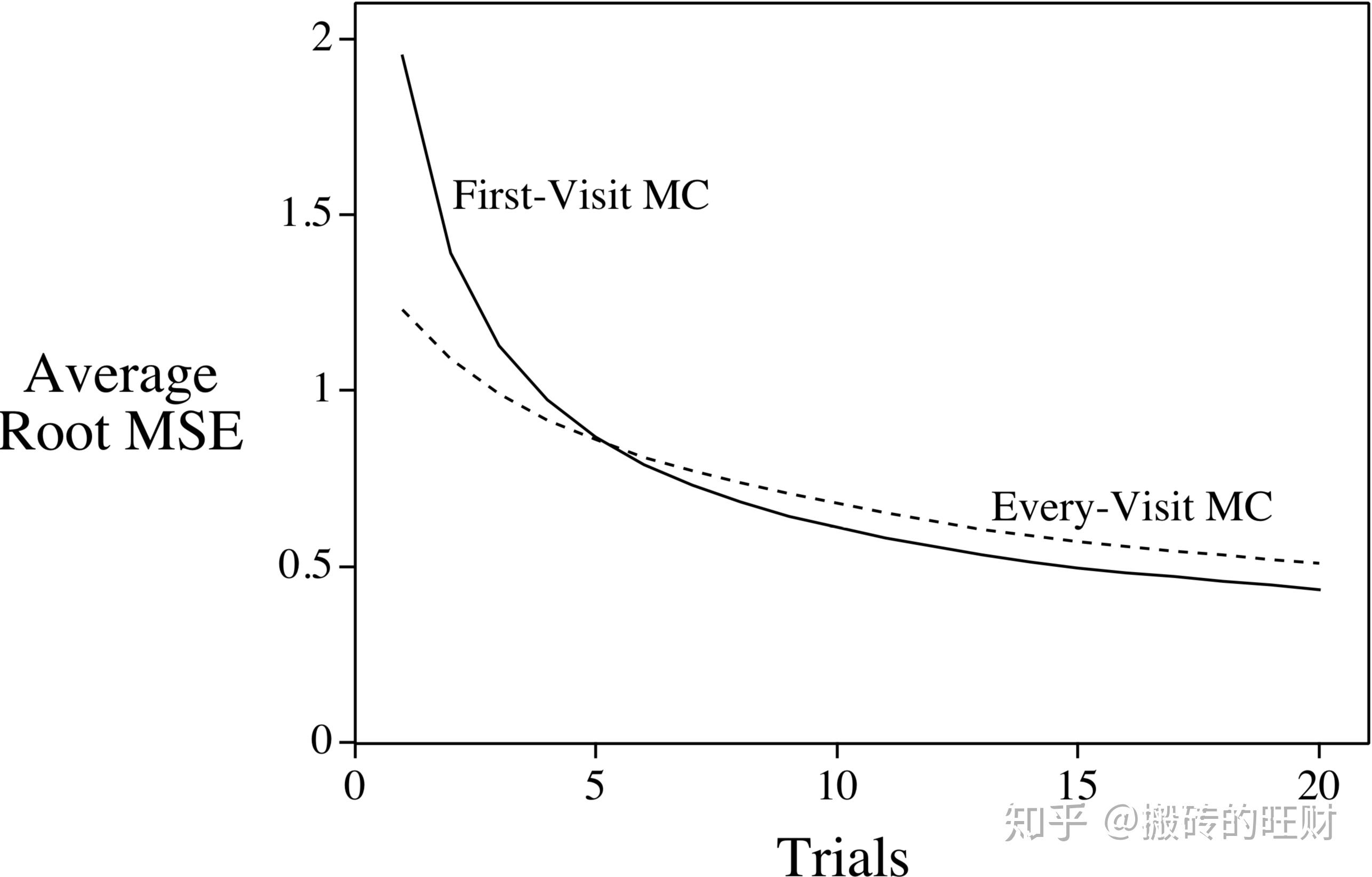

我们可以得出首次访问MC方法和每次访问MC方法的偏差(Bias)和方差(Var)——它们是试验次数 的函数。 均方误差(Mean Squared Error,MSE)是

。

相关概念说明

和

分别表示与图2中

与

转移有关的随机奖励。

表示从

到

(包括最开始的状态

)可能发生的所有状态序列的集合,

表示从

到

(包括状态

)可能发生的所有状态序列的集合。

和

分别表示在抽象链中终止和循环的概率。

其中 。

定义 。

奖励概率定义如下:

因此:

同理,

如果原始的马尔可夫链中奖励是状态转移的确定性函数,那么存在与每个 相关的单个

。但是,如果原始的马尔可夫链中奖励是随机的,那么存在与每个

相关的一组可能的随机

。还值得注意的是,即使原始的马尔可夫链中的所有个体的奖励都是确定性的,

和

仍然可以大于零,因为

和

将是随机的——从

到

和从

到

存在许多不同的路径。

注意:

(1)

其中 是状态

的重访次数。如果

,那么

定理2 状态的值函数(value function)真值是

![[公式]](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjIwLjY1MWV4IiBoZWlnaHQ9IjUuNTA5ZXgiIHN0eWxlPSJmb250LXNpemU6IDE1cHg7IHZlcnRpY2FsLWFsaWduOiAtMi4xNzFleDsiIHZpZXdCb3g9IjAgLTE0MzcuMiA4ODkxLjUgMjM3MiIgcm9sZT0iaW1nIiBmb2N1c2FibGU9ImZhbHNlIiB4bWxucz0iaHR0cDovL3d3dy53My5vcmcvMjAwMC9zdmciPgo8ZGVmcz4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS01NiIgZD0iTTUyIDY0OFE1MiA2NzAgNjUgNjgzSDc2UTExOCA2ODAgMTgxIDY4MFEyOTkgNjgwIDMyMCA2ODNIMzMwUTMzNiA2NzcgMzM2IDY3NFQzMzQgNjU2UTMyOSA2NDEgMzI1IDYzN0gzMDRRMjgyIDYzNSAyNzQgNjM1UTI0NSA2MzAgMjQyIDYyMFEyNDIgNjE4IDI3MSAzNjlUMzAxIDExOEwzNzQgMjM1UTQ0NyAzNTIgNTIwIDQ3MVQ1OTUgNTk0UTU5OSA2MDEgNTk5IDYwOVE1OTkgNjMzIDU1NSA2MzdRNTM3IDYzNyA1MzcgNjQ4UTUzNyA2NDkgNTM5IDY2MVE1NDIgNjc1IDU0NSA2NzlUNTU4IDY4M1E1NjAgNjgzIDU3MCA2ODNUNjA0IDY4MlQ2NjggNjgxUTczNyA2ODEgNzU1IDY4M0g3NjJRNzY5IDY3NiA3NjkgNjcyUTc2OSA2NTUgNzYwIDY0MFE3NTcgNjM3IDc0MyA2MzdRNzMwIDYzNiA3MTkgNjM1VDY5OCA2MzBUNjgyIDYyM1Q2NzAgNjE1VDY2MCA2MDhUNjUyIDU5OVQ2NDUgNTkyTDQ1MiAyODJRMjcyIC05IDI2NiAtMTZRMjYzIC0xOCAyNTkgLTIxTDI0MSAtMjJIMjM0UTIxNiAtMjIgMjE2IC0xNVEyMTMgLTkgMTc3IDMwNVExMzkgNjIzIDEzOCA2MjZRMTMzIDYzNyA3NiA2MzdINTlRNTIgNjQyIDUyIDY0OFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTI4IiBkPSJNOTQgMjUwUTk0IDMxOSAxMDQgMzgxVDEyNyA0ODhUMTY0IDU3NlQyMDIgNjQzVDI0NCA2OTVUMjc3IDcyOVQzMDIgNzUwSDMxNUgzMTlRMzMzIDc1MCAzMzMgNzQxUTMzMyA3MzggMzE2IDcyMFQyNzUgNjY3VDIyNiA1ODFUMTg0IDQ0M1QxNjcgMjUwVDE4NCA1OFQyMjUgLTgxVDI3NCAtMTY3VDMxNiAtMjIwVDMzMyAtMjQxUTMzMyAtMjUwIDMxOCAtMjUwSDMxNUgzMDJMMjc0IC0yMjZRMTgwIC0xNDEgMTM3IC0xNFQ5NCAyNTBaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFUSEktNzMiIGQ9Ik0xMzEgMjg5UTEzMSAzMjEgMTQ3IDM1NFQyMDMgNDE1VDMwMCA0NDJRMzYyIDQ0MiAzOTAgNDE1VDQxOSAzNTVRNDE5IDMyMyA0MDIgMzA4VDM2NCAyOTJRMzUxIDI5MiAzNDAgMzAwVDMyOCAzMjZRMzI4IDM0MiAzMzcgMzU0VDM1NCAzNzJUMzY3IDM3OFEzNjggMzc4IDM2OCAzNzlRMzY4IDM4MiAzNjEgMzg4VDMzNiAzOTlUMjk3IDQwNVEyNDkgNDA1IDIyNyAzNzlUMjA0IDMyNlEyMDQgMzAxIDIyMyAyOTFUMjc4IDI3NFQzMzAgMjU5UTM5NiAyMzAgMzk2IDE2M1EzOTYgMTM1IDM4NSAxMDdUMzUyIDUxVDI4OSA3VDE5NSAtMTBRMTE4IC0xMCA4NiAxOVQ1MyA4N1E1MyAxMjYgNzQgMTQzVDExOCAxNjBRMTMzIDE2MCAxNDYgMTUxVDE2MCAxMjBRMTYwIDk0IDE0MiA3NlQxMTEgNThRMTA5IDU3IDEwOCA1N1QxMDcgNTVRMTA4IDUyIDExNSA0N1QxNDYgMzRUMjAxIDI3UTIzNyAyNyAyNjMgMzhUMzAxIDY2VDMxOCA5N1QzMjMgMTIyUTMyMyAxNTAgMzAyIDE2NFQyNTQgMTgxVDE5NSAxOTZUMTQ4IDIzMVExMzEgMjU2IDEzMSAyODlaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi0yOSIgZD0iTTYwIDc0OUw2NCA3NTBRNjkgNzUwIDc0IDc1MEg4NkwxMTQgNzI2UTIwOCA2NDEgMjUxIDUxNFQyOTQgMjUwUTI5NCAxODIgMjg0IDExOVQyNjEgMTJUMjI0IC03NlQxODYgLTE0M1QxNDUgLTE5NFQxMTMgLTIyN1Q5MCAtMjQ2UTg3IC0yNDkgODYgLTI1MEg3NFE2NiAtMjUwIDYzIC0yNTBUNTggLTI0N1Q1NSAtMjM4UTU2IC0yMzcgNjYgLTIyNVEyMjEgLTY0IDIyMSAyNTBUNjYgNzI1UTU2IDczNyA1NSA3MzhRNTUgNzQ2IDYwIDc0OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTNEIiBkPSJNNTYgMzQ3UTU2IDM2MCA3MCAzNjdINzA3UTcyMiAzNTkgNzIyIDM0N1E3MjIgMzM2IDcwOCAzMjhMMzkwIDMyN0g3MlE1NiAzMzIgNTYgMzQ3Wk01NiAxNTNRNTYgMTY4IDcyIDE3M0g3MDhRNzIyIDE2MyA3MjIgMTUzUTcyMiAxNDAgNzA3IDEzM0g3MFE1NiAxNDAgNTYgMTUzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTUyIiBkPSJNMjMwIDYzN1EyMDMgNjM3IDE5OCA2MzhUMTkzIDY0OVExOTMgNjc2IDIwNCA2ODJRMjA2IDY4MyAzNzggNjgzUTU1MCA2ODIgNTY0IDY4MFE2MjAgNjcyIDY1OCA2NTJUNzEyIDYwNlQ3MzMgNTYzVDczOSA1MjlRNzM5IDQ4NCA3MTAgNDQ1VDY0MyAzODVUNTc2IDM1MVQ1MzggMzM4TDU0NSAzMzNRNjEyIDI5NSA2MTIgMjIzUTYxMiAyMTIgNjA3IDE2MlQ2MDIgODBWNzFRNjAyIDUzIDYwMyA0M1Q2MTQgMjVUNjQwIDE2UTY2OCAxNiA2ODYgMzhUNzEyIDg1UTcxNyA5OSA3MjAgMTAyVDczNSAxMDVRNzU1IDEwNSA3NTUgOTNRNzU1IDc1IDczMSAzNlE2OTMgLTIxIDY0MSAtMjFINjMyUTU3MSAtMjEgNTMxIDRUNDg3IDgyUTQ4NyAxMDkgNTAyIDE2NlQ1MTcgMjM5UTUxNyAyOTAgNDc0IDMxM1E0NTkgMzIwIDQ0OSAzMjFUMzc4IDMyM0gzMDlMMjc3IDE5M1EyNDQgNjEgMjQ0IDU5UTI0NCA1NSAyNDUgNTRUMjUyIDUwVDI2OSA0OFQzMDIgNDZIMzMzUTMzOSAzOCAzMzkgMzdUMzM2IDE5UTMzMiA2IDMyNiAwSDMxMVEyNzUgMiAxODAgMlExNDYgMiAxMTcgMlQ3MSAyVDUwIDFRMzMgMSAzMyAxMFEzMyAxMiAzNiAyNFE0MSA0MyA0NiA0NVE1MCA0NiA2MSA0Nkg2N1E5NCA0NiAxMjcgNDlRMTQxIDUyIDE0NiA2MVExNDkgNjUgMjE4IDMzOVQyODcgNjI4UTI4NyA2MzUgMjMwIDYzN1pNNjMwIDU1NFE2MzAgNTg2IDYwOSA2MDhUNTIzIDYzNlE1MjEgNjM2IDUwMCA2MzZUNDYyIDYzN0g0NDBRMzkzIDYzNyAzODYgNjI3UTM4NSA2MjQgMzUyIDQ5NFQzMTkgMzYxUTMxOSAzNjAgMzg4IDM2MFE0NjYgMzYxIDQ5MiAzNjdRNTU2IDM3NyA1OTIgNDI2UTYwOCA0NDkgNjE5IDQ4NlQ2MzAgNTU0WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTU0IiBkPSJNNDAgNDM3UTIxIDQzNyAyMSA0NDVRMjEgNDUwIDM3IDUwMVQ3MSA2MDJMODggNjUxUTkzIDY2OSAxMDEgNjc3SDU2OUg2NTlRNjkxIDY3NyA2OTcgNjc2VDcwNCA2NjdRNzA0IDY2MSA2ODcgNTUzVDY2OCA0NDRRNjY4IDQzNyA2NDkgNDM3UTY0MCA0MzcgNjM3IDQzN1Q2MzEgNDQyTDYyOSA0NDVRNjI5IDQ1MSA2MzUgNDkwVDY0MSA1NTFRNjQxIDU4NiA2MjggNjA0VDU3MyA2MjlRNTY4IDYzMCA1MTUgNjMxUTQ2OSA2MzEgNDU3IDYzMFQ0MzkgNjIyUTQzOCA2MjEgMzY4IDM0M1QyOTggNjBRMjk4IDQ4IDM4NiA0NlE0MTggNDYgNDI3IDQ1VDQzNiAzNlE0MzYgMzEgNDMzIDIyUTQyOSA0IDQyNCAxTDQyMiAwUTQxOSAwIDQxNSAwUTQxMCAwIDM2MyAxVDIyOCAyUTk5IDIgNjQgMEg0OVE0MyA2IDQzIDlUNDUgMjdRNDkgNDAgNTUgNDZIODNIOTRRMTc0IDQ2IDE4OSA1NVExOTAgNTYgMTkxIDU2UTE5NiA1OSAyMDEgNzZUMjQxIDIzM1EyNTggMzAxIDI2OSAzNDRRMzM5IDYxOSAzMzkgNjI1UTMzOSA2MzAgMzEwIDYzMEgyNzlRMjEyIDYzMCAxOTEgNjI0UTE0NiA2MTQgMTIxIDU4M1Q2NyA0NjdRNjAgNDQ1IDU3IDQ0MVQ0MyA0MzdINDBaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi0yQiIgZD0iTTU2IDIzN1Q1NiAyNTBUNzAgMjcwSDM2OVY0MjBMMzcwIDU3MFEzODAgNTgzIDM4OSA1ODNRNDAyIDU4MyA0MDkgNTY4VjI3MEg3MDdRNzIyIDI2MiA3MjIgMjUwVDcwNyAyMzBINDA5Vi02OFE0MDEgLTgyIDM5MSAtODJIMzg5SDM4N1EzNzUgLTgyIDM2OSAtNjhWMjMwSDcwUTU2IDIzNyA1NiAyNTBaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFUSEktNTAiIGQ9Ik0yODcgNjI4UTI4NyA2MzUgMjMwIDYzN1EyMDYgNjM3IDE5OSA2MzhUMTkyIDY0OFExOTIgNjQ5IDE5NCA2NTlRMjAwIDY3OSAyMDMgNjgxVDM5NyA2ODNRNTg3IDY4MiA2MDAgNjgwUTY2NCA2NjkgNzA3IDYzMVQ3NTEgNTMwUTc1MSA0NTMgNjg1IDM4OVE2MTYgMzIxIDUwNyAzMDNRNTAwIDMwMiA0MDIgMzAxSDMwN0wyNzcgMTgyUTI0NyA2NiAyNDcgNTlRMjQ3IDU1IDI0OCA1NFQyNTUgNTBUMjcyIDQ4VDMwNSA0NkgzMzZRMzQyIDM3IDM0MiAzNVEzNDIgMTkgMzM1IDVRMzMwIDAgMzE5IDBRMzE2IDAgMjgyIDFUMTgyIDJRMTIwIDIgODcgMlQ1MSAxUTMzIDEgMzMgMTFRMzMgMTMgMzYgMjVRNDAgNDEgNDQgNDNUNjcgNDZROTQgNDYgMTI3IDQ5UTE0MSA1MiAxNDYgNjFRMTQ5IDY1IDIxOCAzMzlUMjg3IDYyOFpNNjQ1IDU1NFE2NDUgNTY3IDY0MyA1NzVUNjM0IDU5N1Q2MDkgNjE5VDU2MCA2MzVRNTUzIDYzNiA0ODAgNjM3UTQ2MyA2MzcgNDQ1IDYzN1Q0MTYgNjM2VDQwNCA2MzZRMzkxIDYzNSAzODYgNjI3UTM4NCA2MjEgMzY3IDU1MFQzMzIgNDEyVDMxNCAzNDRRMzE0IDM0MiAzOTUgMzQySDQwN0g0MzBRNTQyIDM0MiA1OTAgMzkyUTYxNyA0MTkgNjMxIDQ3MVQ2NDUgNTU0WiI+PC9wYXRoPgo8L2RlZnM+CjxnIHN0cm9rZT0iY3VycmVudENvbG9yIiBmaWxsPSJjdXJyZW50Q29sb3IiIHN0cm9rZS13aWR0aD0iMCIgdHJhbnNmb3JtPSJtYXRyaXgoMSAwIDAgLTEgMCAwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTU2IiB4PSIwIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoOTM2LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIzODkiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSI4NTkiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tM0QiIHg9IjI0NjIiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgzNTE4LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTIiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTQiIHg9IjEwNzQiIHk9Ii0yMTMiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMkIiIHg9IjUwOTgiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg1ODc3LDApIj4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMzQyLDApIj4KPHJlY3Qgc3Ryb2tlPSJub25lIiB3aWR0aD0iMTM2MCIgaGVpZ2h0PSI2MCIgeD0iMCIgeT0iMjIwIj48L3JlY3Q+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDE0Myw2NzcpIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTAiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzMiIHg9IjkwOCIgeT0iLTIxMyI+PC91c2U+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNjAsLTcwNCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS01MCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS01NCIgeD0iOTA4IiB5PSItMjEzIj48L3VzZT4KPC9nPgo8L2c+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNzY5OSwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTUyIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIxMDc0IiB5PSItMjEzIj48L3VzZT4KPC9nPgo8L2c+Cjwvc3ZnPg==)

证明:

图2中状态 的值可以从Bellman方程推导出:

因此,

定理3 首次访问MC方法是无偏的,即![[公式]](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjM1LjkzNWV4IiBoZWlnaHQ9IjMuMzQzZXgiIHN0eWxlPSJmb250LXNpemU6IDE1cHg7IHZlcnRpY2FsLWFsaWduOiAtMS4wMDVleDsiIHZpZXdCb3g9IjAgLTEwMDYuNiAxNTQ3MiAxNDM5LjIiIHJvbGU9ImltZyIgZm9jdXNhYmxlPSJmYWxzZSIgeG1sbnM9Imh0dHA6Ly93d3cudzMub3JnLzIwMDAvc3ZnIj4KPGRlZnM+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi00MiIgZD0iTTEzMSA2MjJRMTI0IDYyOSAxMjAgNjMxVDEwNCA2MzRUNjEgNjM3SDI4VjY4M0gyMjlIMjY3SDM0NlE0MjMgNjgzIDQ1OSA2NzhUNTMxIDY1MVE1NzQgNjI3IDU5OSA1OTBUNjI0IDUxMlE2MjQgNDYxIDU4MyA0MTlUNDc2IDM2MEw0NjYgMzU3UTUzOSAzNDggNTk1IDMwMlQ2NTEgMTg3UTY1MSAxMTkgNjAwIDY3VDQ2OSAzUTQ1NiAxIDI0MiAwSDI4VjQ2SDYxUTEwMyA0NyAxMTIgNDlUMTMxIDYxVjYyMlpNNTExIDUxM1E1MTEgNTYwIDQ4NSA1OTRUNDE2IDYzNlE0MTUgNjM2IDQwMyA2MzZUMzcxIDYzNlQzMzMgNjM3UTI2NiA2MzcgMjUxIDYzNlQyMzIgNjI4UTIyOSA2MjQgMjI5IDQ5OVYzNzRIMzEyTDM5NiAzNzVMNDA2IDM3N1E0MTAgMzc4IDQxNyAzODBUNDQyIDM5M1Q0NzQgNDE3VDQ5OSA0NTZUNTExIDUxM1pNNTM3IDE4OFE1MzcgMjM5IDUwOSAyODJUNDMwIDMzNkwzMjkgMzM3SDIyOVYyMDBWMTE2UTIyOSA1NyAyMzQgNTJRMjQwIDQ3IDMzNCA0N0gzODNRNDI1IDQ3IDQ0MyA1M1E0ODYgNjcgNTExIDEwNFQ1MzcgMTg4WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNjkiIGQ9Ik02OSA2MDlRNjkgNjM3IDg3IDY1M1QxMzEgNjY5UTE1NCA2NjcgMTcxIDY1MlQxODggNjA5UTE4OCA1NzkgMTcxIDU2NFQxMjkgNTQ5UTEwNCA1NDkgODcgNTY0VDY5IDYwOVpNMjQ3IDBRMjMyIDMgMTQzIDNRMTMyIDMgMTA2IDNUNTYgMUwzNCAwSDI2VjQ2SDQyUTcwIDQ2IDkxIDQ5UTEwMCA1MyAxMDIgNjBUMTA0IDEwMlYyMDVWMjkzUTEwNCAzNDUgMTAyIDM1OVQ4OCAzNzhRNzQgMzg1IDQxIDM4NUgzMFY0MDhRMzAgNDMxIDMyIDQzMUw0MiA0MzJRNTIgNDMzIDcwIDQzNFQxMDYgNDM2UTEyMyA0MzcgMTQyIDQzOFQxNzEgNDQxVDE4MiA0NDJIMTg1VjYyUTE5MCA1MiAxOTcgNTBUMjMyIDQ2SDI1NVYwSDI0N1oiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTYxIiBkPSJNMTM3IDMwNVQxMTUgMzA1VDc4IDMyMFQ2MyAzNTlRNjMgMzk0IDk3IDQyMVQyMTggNDQ4UTI5MSA0NDggMzM2IDQxNlQzOTYgMzQwUTQwMSAzMjYgNDAxIDMwOVQ0MDIgMTk0VjEyNFE0MDIgNzYgNDA3IDU4VDQyOCA0MFE0NDMgNDAgNDQ4IDU2VDQ1MyAxMDlWMTQ1SDQ5M1YxMDZRNDkyIDY2IDQ5MCA1OVE0ODEgMjkgNDU1IDEyVDQwMCAtNlQzNTMgMTJUMzI5IDU0VjU4TDMyNyA1NVEzMjUgNTIgMzIyIDQ5VDMxNCA0MFQzMDIgMjlUMjg3IDE3VDI2OSA2VDI0NyAtMlQyMjEgLThUMTkwIC0xMVExMzAgLTExIDgyIDIwVDM0IDEwN1EzNCAxMjggNDEgMTQ3VDY4IDE4OFQxMTYgMjI1VDE5NCAyNTNUMzA0IDI2OEgzMThWMjkwUTMxOCAzMjQgMzEyIDM0MFEyOTAgNDExIDIxNSA0MTFRMTk3IDQxMSAxODEgNDEwVDE1NiA0MDZUMTQ4IDQwM1ExNzAgMzg4IDE3MCAzNTlRMTcwIDMzNCAxNTQgMzIwWk0xMjYgMTA2UTEyNiA3NSAxNTAgNTFUMjA5IDI2UTI0NyAyNiAyNzYgNDlUMzE1IDEwOVEzMTcgMTE2IDMxOCAxNzVRMzE4IDIzMyAzMTcgMjMzUTMwOSAyMzMgMjk2IDIzMlQyNTEgMjIzVDE5MyAyMDNUMTQ3IDE2NlQxMjYgMTA2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNzMiIGQ9Ik0yOTUgMzE2UTI5NSAzNTYgMjY4IDM4NVQxOTAgNDE0UTE1NCA0MTQgMTI4IDQwMVE5OCAzODIgOTggMzQ5UTk3IDM0NCA5OCAzMzZUMTE0IDMxMlQxNTcgMjg3UTE3NSAyODIgMjAxIDI3OFQyNDUgMjY5VDI3NyAyNTZRMjk0IDI0OCAzMTAgMjM2VDM0MiAxOTVUMzU5IDEzM1EzNTkgNzEgMzIxIDMxVDE5OCAtMTBIMTkwUTEzOCAtMTAgOTQgMjZMODYgMTlMNzcgMTBRNzEgNCA2NSAtMUw1NCAtMTFINDZINDJRMzkgLTExIDMzIC01Vjc0VjEzMlEzMyAxNTMgMzUgMTU3VDQ1IDE2Mkg1NFE2NiAxNjIgNzAgMTU4VDc1IDE0NlQ4MiAxMTlUMTAxIDc3UTEzNiAyNiAxOTggMjZRMjk1IDI2IDI5NSAxMDRRMjk1IDEzMyAyNzcgMTUxUTI1NyAxNzUgMTk0IDE4N1QxMTEgMjEwUTc1IDIyNyA1NCAyNTZUMzMgMzE4UTMzIDM1NyA1MCAzODRUOTMgNDI0VDE0MyA0NDJUMTg3IDQ0N0gxOThRMjM4IDQ0NyAyNjggNDMyTDI4MyA0MjRMMjkyIDQzMVEzMDIgNDQwIDMxNCA0NDhIMzIySDMyNlEzMjkgNDQ4IDMzNSA0NDJWMzEwTDMyOSAzMDRIMzAxUTI5NSAzMTAgMjk1IDMxNloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS00NiIgZD0iTTQ4IDFRMzEgMSAzMSAxMVEzMSAxMyAzNCAyNVEzOCA0MSA0MiA0M1Q2NSA0NlE5MiA0NiAxMjUgNDlRMTM5IDUyIDE0NCA2MVExNDYgNjYgMjE1IDM0MlQyODUgNjIyUTI4NSA2MjkgMjgxIDYyOVEyNzMgNjMyIDIyOCA2MzRIMTk3UTE5MSA2NDAgMTkxIDY0MlQxOTMgNjU5UTE5NyA2NzYgMjAzIDY4MEg3NDJRNzQ5IDY3NiA3NDkgNjY5UTc0OSA2NjQgNzM2IDU1N1Q3MjIgNDQ3UTcyMCA0NDAgNzAyIDQ0MEg2OTBRNjgzIDQ0NSA2ODMgNDUzUTY4MyA0NTQgNjg2IDQ3N1Q2ODkgNTMwUTY4OSA1NjAgNjgyIDU3OVQ2NjMgNjEwVDYyNiA2MjZUNTc1IDYzM1Q1MDMgNjM0SDQ4MFEzOTggNjMzIDM5MyA2MzFRMzg4IDYyOSAzODYgNjIzUTM4NSA2MjIgMzUyIDQ5MkwzMjAgMzYzSDM3NVEzNzggMzYzIDM5OCAzNjNUNDI2IDM2NFQ0NDggMzY3VDQ3MiAzNzRUNDg5IDM4NlE1MDIgMzk4IDUxMSA0MTlUNTI0IDQ1N1Q1MjkgNDc1UTUzMiA0ODAgNTQ4IDQ4MEg1NjBRNTY3IDQ3NSA1NjcgNDcwUTU2NyA0NjcgNTM2IDMzOVQ1MDIgMjA3UTUwMCAyMDAgNDgyIDIwMEg0NzBRNDYzIDIwNiA0NjMgMjEyUTQ2MyAyMTUgNDY4IDIzNFQ0NzMgMjc0UTQ3MyAzMDMgNDUzIDMxMFQzNjQgMzE3SDMwOUwyNzcgMTkwUTI0NSA2NiAyNDUgNjBRMjQ1IDQ2IDMzNCA0NkgzNTlRMzY1IDQwIDM2NSAzOVQzNjMgMTlRMzU5IDYgMzUzIDBIMzM2UTI5NSAyIDE4NSAyUTEyMCAyIDg2IDJUNDggMVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS02RSIgZD0iTTIxIDI4N1EyMiAyOTMgMjQgMzAzVDM2IDM0MVQ1NiAzODhUODkgNDI1VDEzNSA0NDJRMTcxIDQ0MiAxOTUgNDI0VDIyNSAzOTBUMjMxIDM2OVEyMzEgMzY3IDIzMiAzNjdMMjQzIDM3OFEzMDQgNDQyIDM4MiA0NDJRNDM2IDQ0MiA0NjkgNDE1VDUwMyAzMzZUNDY1IDE3OVQ0MjcgNTJRNDI3IDI2IDQ0NCAyNlE0NTAgMjYgNDUzIDI3UTQ4MiAzMiA1MDUgNjVUNTQwIDE0NVE1NDIgMTUzIDU2MCAxNTNRNTgwIDE1MyA1ODAgMTQ1UTU4MCAxNDQgNTc2IDEzMFE1NjggMTAxIDU1NCA3M1Q1MDggMTdUNDM5IC0xMFEzOTIgLTEwIDM3MSAxN1QzNTAgNzNRMzUwIDkyIDM4NiAxOTNUNDIzIDM0NVE0MjMgNDA0IDM3OSA0MDRIMzc0UTI4OCA0MDQgMjI5IDMwM0wyMjIgMjkxTDE4OSAxNTdRMTU2IDI2IDE1MSAxNlExMzggLTExIDEwOCAtMTFROTUgLTExIDg3IC01VDc2IDdUNzQgMTdRNzQgMzAgMTEyIDE4MFQxNTIgMzQzUTE1MyAzNDggMTUzIDM2NlExNTMgNDA1IDEyOSA0MDVROTEgNDA1IDY2IDMwNVE2MCAyODUgNjAgMjg0UTU4IDI3OCA0MSAyNzhIMjdRMjEgMjg0IDIxIDI4N1oiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTI4IiBkPSJNOTQgMjUwUTk0IDMxOSAxMDQgMzgxVDEyNyA0ODhUMTY0IDU3NlQyMDIgNjQzVDI0NCA2OTVUMjc3IDcyOVQzMDIgNzUwSDMxNUgzMTlRMzMzIDc1MCAzMzMgNzQxUTMzMyA3MzggMzE2IDcyMFQyNzUgNjY3VDIyNiA1ODFUMTg0IDQ0M1QxNjcgMjUwVDE4NCA1OFQyMjUgLTgxVDI3NCAtMTY3VDMxNiAtMjIwVDMzMyAtMjQxUTMzMyAtMjUwIDMxOCAtMjUwSDMxNUgzMDJMMjc0IC0yMjZRMTgwIC0xNDEgMTM3IC0xNFQ5NCAyNTBaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFUSEktNzMiIGQ9Ik0xMzEgMjg5UTEzMSAzMjEgMTQ3IDM1NFQyMDMgNDE1VDMwMCA0NDJRMzYyIDQ0MiAzOTAgNDE1VDQxOSAzNTVRNDE5IDMyMyA0MDIgMzA4VDM2NCAyOTJRMzUxIDI5MiAzNDAgMzAwVDMyOCAzMjZRMzI4IDM0MiAzMzcgMzU0VDM1NCAzNzJUMzY3IDM3OFEzNjggMzc4IDM2OCAzNzlRMzY4IDM4MiAzNjEgMzg4VDMzNiAzOTlUMjk3IDQwNVEyNDkgNDA1IDIyNyAzNzlUMjA0IDMyNlEyMDQgMzAxIDIyMyAyOTFUMjc4IDI3NFQzMzAgMjU5UTM5NiAyMzAgMzk2IDE2M1EzOTYgMTM1IDM4NSAxMDdUMzUyIDUxVDI4OSA3VDE5NSAtMTBRMTE4IC0xMCA4NiAxOVQ1MyA4N1E1MyAxMjYgNzQgMTQzVDExOCAxNjBRMTMzIDE2MCAxNDYgMTUxVDE2MCAxMjBRMTYwIDk0IDE0MiA3NlQxMTEgNThRMTA5IDU3IDEwOCA1N1QxMDcgNTVRMTA4IDUyIDExNSA0N1QxNDYgMzRUMjAxIDI3UTIzNyAyNyAyNjMgMzhUMzAxIDY2VDMxOCA5N1QzMjMgMTIyUTMyMyAxNTAgMzAyIDE2NFQyNTQgMTgxVDE5NSAxOTZUMTQ4IDIzMVExMzEgMjU2IDEzMSAyODlaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi0yOSIgZD0iTTYwIDc0OUw2NCA3NTBRNjkgNzUwIDc0IDc1MEg4NkwxMTQgNzI2UTIwOCA2NDEgMjUxIDUxNFQyOTQgMjUwUTI5NCAxODIgMjg0IDExOVQyNjEgMTJUMjI0IC03NlQxODYgLTE0M1QxNDUgLTE5NFQxMTMgLTIyN1Q5MCAtMjQ2UTg3IC0yNDkgODYgLTI1MEg3NFE2NiAtMjUwIDYzIC0yNTBUNTggLTI0N1Q1NSAtMjM4UTU2IC0yMzcgNjYgLTIyNVEyMjEgLTY0IDIyMSAyNTBUNjYgNzI1UTU2IDczNyA1NSA3MzhRNTUgNzQ2IDYwIDc0OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTNEIiBkPSJNNTYgMzQ3UTU2IDM2MCA3MCAzNjdINzA3UTcyMiAzNTkgNzIyIDM0N1E3MjIgMzM2IDcwOCAzMjhMMzkwIDMyN0g3MlE1NiAzMzIgNTYgMzQ3Wk01NiAxNTNRNTYgMTY4IDcyIDE3M0g3MDhRNzIyIDE2MyA3MjIgMTUzUTcyMiAxNDAgNzA3IDEzM0g3MFE1NiAxNDAgNTYgMTUzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTU2IiBkPSJNNTIgNjQ4UTUyIDY3MCA2NSA2ODNINzZRMTE4IDY4MCAxODEgNjgwUTI5OSA2ODAgMzIwIDY4M0gzMzBRMzM2IDY3NyAzMzYgNjc0VDMzNCA2NTZRMzI5IDY0MSAzMjUgNjM3SDMwNFEyODIgNjM1IDI3NCA2MzVRMjQ1IDYzMCAyNDIgNjIwUTI0MiA2MTggMjcxIDM2OVQzMDEgMTE4TDM3NCAyMzVRNDQ3IDM1MiA1MjAgNDcxVDU5NSA1OTRRNTk5IDYwMSA1OTkgNjA5UTU5OSA2MzMgNTU1IDYzN1E1MzcgNjM3IDUzNyA2NDhRNTM3IDY0OSA1MzkgNjYxUTU0MiA2NzUgNTQ1IDY3OVQ1NTggNjgzUTU2MCA2ODMgNTcwIDY4M1Q2MDQgNjgyVDY2OCA2ODFRNzM3IDY4MSA3NTUgNjgzSDc2MlE3NjkgNjc2IDc2OSA2NzJRNzY5IDY1NSA3NjAgNjQwUTc1NyA2MzcgNzQzIDYzN1E3MzAgNjM2IDcxOSA2MzVUNjk4IDYzMFQ2ODIgNjIzVDY3MCA2MTVUNjYwIDYwOFQ2NTIgNTk5VDY0NSA1OTJMNDUyIDI4MlEyNzIgLTkgMjY2IC0xNlEyNjMgLTE4IDI1OSAtMjFMMjQxIC0yMkgyMzRRMjE2IC0yMiAyMTYgLTE1UTIxMyAtOSAxNzcgMzA1UTEzOSA2MjMgMTM4IDYyNlExMzMgNjM3IDc2IDYzN0g1OVE1MiA2NDIgNTIgNjQ4WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tMjIxMiIgZD0iTTg0IDIzN1Q4NCAyNTBUOTggMjcwSDY3OVE2OTQgMjYyIDY5NCAyNTBUNjc5IDIzMEg5OFE4NCAyMzcgODQgMjUwWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTQ1IiBkPSJNNDkyIDIxM1E0NzIgMjEzIDQ3MiAyMjZRNDcyIDIzMCA0NzcgMjUwVDQ4MiAyODVRNDgyIDMxNiA0NjEgMzIzVDM2NCAzMzBIMzEyUTMxMSAzMjggMjc3IDE5MlQyNDMgNTJRMjQzIDQ4IDI1NCA0OFQzMzQgNDZRNDI4IDQ2IDQ1OCA0OFQ1MTggNjFRNTY3IDc3IDU5OSAxMTdUNjcwIDI0OFE2ODAgMjcwIDY4MyAyNzJRNjkwIDI3NCA2OTggMjc0UTcxOCAyNzQgNzE4IDI2MVE2MTMgNyA2MDggMlE2MDUgMCAzMjIgMEgxMzNRMzEgMCAzMSAxMVEzMSAxMyAzNCAyNVEzOCA0MSA0MiA0M1Q2NSA0NlE5MiA0NiAxMjUgNDlRMTM5IDUyIDE0NCA2MVExNDYgNjYgMjE1IDM0MlQyODUgNjIyUTI4NSA2MjkgMjgxIDYyOVEyNzMgNjMyIDIyOCA2MzRIMTk3UTE5MSA2NDAgMTkxIDY0MlQxOTMgNjU5UTE5NyA2NzYgMjAzIDY4MEg3NTdRNzY0IDY3NiA3NjQgNjY5UTc2NCA2NjQgNzUxIDU1N1Q3MzcgNDQ3UTczNSA0NDAgNzE3IDQ0MEg3MDVRNjk4IDQ0NSA2OTggNDUzTDcwMSA0NzZRNzA0IDUwMCA3MDQgNTI4UTcwNCA1NTggNjk3IDU3OFQ2NzggNjA5VDY0MyA2MjVUNTk2IDYzMlQ1MzIgNjM0SDQ4NVEzOTcgNjMzIDM5MiA2MzFRMzg4IDYyOSAzODYgNjIyUTM4NSA2MTkgMzU1IDQ5OVQzMjQgMzc3UTM0NyAzNzYgMzcyIDM3NkgzOThRNDY0IDM3NiA0ODkgMzkxVDUzNCA0NzJRNTM4IDQ4OCA1NDAgNDkwVDU1NyA0OTNRNTYyIDQ5MyA1NjUgNDkzVDU3MCA0OTJUNTcyIDQ5MVQ1NzQgNDg3VDU3NyA0ODNMNTQ0IDM1MVE1MTEgMjE4IDUwOCAyMTZRNTA1IDIxMyA0OTIgMjEzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tN0IiIGQ9Ik00MzQgLTIzMVE0MzQgLTI0NCA0MjggLTI1MEg0MTBRMjgxIC0yNTAgMjMwIC0xODRRMjI1IC0xNzcgMjIyIC0xNzJUMjE3IC0xNjFUMjEzIC0xNDhUMjExIC0xMzNUMjEwIC0xMTFUMjA5IC04NFQyMDkgLTQ3VDIwOSAwUTIwOSAyMSAyMDkgNTNRMjA4IDE0MiAyMDQgMTUzUTIwMyAxNTQgMjAzIDE1NVExODkgMTkxIDE1MyAyMTFUODIgMjMxUTcxIDIzMSA2OCAyMzRUNjUgMjUwVDY4IDI2NlQ4MiAyNjlRMTE2IDI2OSAxNTIgMjg5VDIwMyAzNDVRMjA4IDM1NiAyMDggMzc3VDIwOSA1MjlWNTc5UTIwOSA2MzQgMjE1IDY1NlQyNDQgNjk4UTI3MCA3MjQgMzI0IDc0MFEzNjEgNzQ4IDM3NyA3NDlRMzc5IDc0OSAzOTAgNzQ5VDQwOCA3NTBINDI4UTQzNCA3NDQgNDM0IDczMlE0MzQgNzE5IDQzMSA3MTZRNDI5IDcxMyA0MTUgNzEzUTM2MiA3MTAgMzMyIDY4OVQyOTYgNjQ3UTI5MSA2MzQgMjkxIDQ5OVY0MTdRMjkxIDM3MCAyODggMzUzVDI3MSAzMTRRMjQwIDI3MSAxODQgMjU1TDE3MCAyNTBMMTg0IDI0NVEyMDIgMjM5IDIyMCAyMzBUMjYyIDE5NlQyOTAgMTM3UTI5MSAxMzEgMjkxIDFRMjkxIC0xMzQgMjk2IC0xNDdRMzA2IC0xNzQgMzM5IC0xOTJUNDE1IC0yMTNRNDI5IC0yMTMgNDMxIC0yMTZRNDM0IC0yMTkgNDM0IC0yMzFaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi03RCIgZD0iTTY1IDczMVE2NSA3NDUgNjggNzQ3VDg4IDc1MFExNzEgNzUwIDIxNiA3MjVUMjc5IDY3MFEyODggNjQ5IDI4OSA2MzVUMjkxIDUwMVEyOTIgMzYyIDI5MyAzNTdRMzA2IDMxMiAzNDUgMjkxVDQxNyAyNjlRNDI4IDI2OSA0MzEgMjY2VDQzNCAyNTBUNDMxIDIzNFQ0MTcgMjMxUTM4MCAyMzEgMzQ1IDIxMFQyOTggMTU3UTI5MyAxNDMgMjkyIDEyMVQyOTEgLTI4Vi03OVEyOTEgLTEzNCAyODUgLTE1NlQyNTYgLTE5OFEyMDIgLTI1MCA4OSAtMjUwUTcxIC0yNTAgNjggLTI0N1Q2NSAtMjMwUTY1IC0yMjQgNjUgLTIyM1Q2NiAtMjE4VDY5IC0yMTRUNzcgLTIxM1E5MSAtMjEzIDEwOCAtMjEwVDE0NiAtMjAwVDE4MyAtMTc3VDIwNyAtMTM5UTIwOCAtMTM0IDIwOSAzTDIxMCAxMzlRMjIzIDE5NiAyODAgMjMwUTMxNSAyNDcgMzMwIDI1MFEzMDUgMjU3IDI4MCAyNzBRMjI1IDMwNCAyMTIgMzUyTDIxMCAzNjJMMjA5IDQ5OFEyMDggNjM1IDIwNyA2NDBRMTk1IDY4MCAxNTQgNjk2VDc3IDcxM1E2OCA3MTMgNjcgNzE2VDY1IDczMVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpTWjEtN0IiIGQ9Ik00NzcgLTM0M0w0NzEgLTM0OUg0NThRNDMyIC0zNDkgMzY3IC0zMjVUMjczIC0yNjNRMjU4IC0yNDUgMjUwIC0yMTJMMjQ5IC01MVEyNDkgLTI3IDI0OSAxMlEyNDggMTE4IDI0NCAxMjhRMjQzIDEyOSAyNDMgMTMwUTIyMCAxODkgMTIxIDIyOFExMDkgMjMyIDEwNyAyMzVUMTA1IDI1MFExMDUgMjU2IDEwNSAyNTdUMTA1IDI2MVQxMDcgMjY1VDExMSAyNjhUMTE4IDI3MlQxMjggMjc2VDE0MiAyODNUMTYyIDI5MVEyMjQgMzI0IDI0MyAzNzFRMjQzIDM3MiAyNDQgMzczUTI0OCAzODQgMjQ5IDQ2OVEyNDkgNDc1IDI0OSA0ODlRMjQ5IDUyOCAyNDkgNTUyTDI1MCA3MTRRMjUzIDcyOCAyNTYgNzM2VDI3MSA3NjFUMjk5IDc4OVQzNDcgODE2VDQyMiA4NDNRNDQwIDg0OSA0NDEgODQ5SDQ0M1E0NDUgODQ5IDQ0NyA4NDlUNDUyIDg1MFQ0NTcgODUwSDQ3MUw0NzcgODQ0VjgzMFE0NzcgODIwIDQ3NiA4MTdUNDcwIDgxMVQ0NTkgODA3VDQzNyA4MDFUNDA0IDc4NVEzNTMgNzYwIDMzOCA3MjRRMzMzIDcxMCAzMzMgNTUwUTMzMyA1MjYgMzMzIDQ5MlQzMzQgNDQ3UTMzNCAzOTMgMzI3IDM2OFQyOTUgMzE4UTI1NyAyODAgMTgxIDI1NUwxNjkgMjUxTDE4NCAyNDVRMzE4IDE5OCAzMzIgMTEyUTMzMyAxMDYgMzMzIC00OVEzMzMgLTIwOSAzMzggLTIyM1EzNTEgLTI1NSAzOTEgLTI3N1Q0NjkgLTMwOVE0NzcgLTMxMSA0NzcgLTMyOVYtMzQzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSlNaMS03RCIgZD0iTTExMCA4NDlMMTE1IDg1MFExMjAgODUwIDEyNSA4NTBRMTUxIDg1MCAyMTUgODI2VDMwOSA3NjRRMzI0IDc0NyAzMzIgNzE0TDMzMyA1NTJRMzMzIDUyOCAzMzMgNDg5UTMzNCAzODMgMzM4IDM3M1EzMzkgMzcyIDMzOSAzNzFRMzUzIDMzNiAzOTEgMzEwVDQ2OSAyNzFRNDc3IDI2OCA0NzcgMjUxUTQ3NyAyNDEgNDc2IDIzN1Q0NzIgMjMyVDQ1NiAyMjVUNDI4IDIxNFEzNTcgMTc5IDMzOSAxMzBRMzM5IDEyOSAzMzggMTI4UTMzNCAxMTcgMzMzIDMyUTMzMyAyNiAzMzMgMTJRMzMzIC0yNyAzMzMgLTUxTDMzMiAtMjEyUTMyOCAtMjI4IDMyMyAtMjQwVDMwMiAtMjcxVDI1NSAtMzA3VDE3NSAtMzM4UTEzOSAtMzQ5IDEyNSAtMzQ5VDEwOCAtMzQ2VDEwNSAtMzI5UTEwNSAtMzE0IDEwNyAtMzEyVDEzMCAtMzA0UTIzMyAtMjcxIDI0OCAtMjA5UTI0OSAtMjAzIDI0OSAtNDlWNTdRMjQ5IDEwNiAyNTMgMTI1VDI3MyAxNjdRMzA3IDIxMyAzOTggMjQ1TDQxMyAyNTFMNDAxIDI1NVEyNjUgMzAwIDI1MCAzODlRMjQ5IDM5NSAyNDkgNTUwUTI0OSA3MTAgMjQ0IDcyNFEyMjQgNzc0IDExMiA4MTFRMTA1IDgxMyAxMDUgODMwUTEwNSA4NDUgMTEwIDg0OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTMwIiBkPSJNOTYgNTg1UTE1MiA2NjYgMjQ5IDY2NlEyOTcgNjY2IDM0NSA2NDBUNDIzIDU0OFE0NjAgNDY1IDQ2MCAzMjBRNDYwIDE2NSA0MTcgODNRMzk3IDQxIDM2MiAxNlQzMDEgLTE1VDI1MCAtMjJRMjI0IC0yMiAxOTggLTE2VDEzNyAxNlQ4MiA4M1EzOSAxNjUgMzkgMzIwUTM5IDQ5NCA5NiA1ODVaTTMyMSA1OTdRMjkxIDYyOSAyNTAgNjI5UTIwOCA2MjkgMTc4IDU5N1ExNTMgNTcxIDE0NSA1MjVUMTM3IDMzM1ExMzcgMTc1IDE0NSAxMjVUMTgxIDQ2UTIwOSAxNiAyNTAgMTZRMjkwIDE2IDMxOCA0NlEzNDcgNzYgMzU0IDEzMFQzNjIgMzMzUTM2MiA0NzggMzU0IDUyNFQzMjEgNTk3WiI+PC9wYXRoPgo8L2RlZnM+CjxnIHN0cm9rZT0iY3VycmVudENvbG9yIiBmaWxsPSJjdXJyZW50Q29sb3IiIHN0cm9rZS13aWR0aD0iMCIgdHJhbnNmb3JtPSJtYXRyaXgoMSAwIDAgLTEgMCAwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNDIiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTY5IiB4PSI3MDgiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTYxIiB4PSI5ODciIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTczIiB4PSIxNDg3IiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTQ2IiB4PSIyNjYxIiB5PSI1ODEiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNkUiIHg9IjI2NjEiIHk9Ii0zNTAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgyNjc4LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIzODkiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSI4NTkiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tM0QiIHg9IjQyMDQiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS01NiIgeD0iNTI2MSIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDYxOTcsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI4IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzMiIHg9IjM4OSIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMjkiIHg9Ijg1OSIgeT0iMCI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yMjEyIiB4PSI3NjY4IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNDUiIHg9Ijg2NjgiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg5NTk5LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KU1oxLTdCIiB4PSIwIiB5PSItMSI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDU4MywwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTU2IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTQ2IiB4PSIxMTY3IiB5PSI0ODgiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNkUiIHg9IjgyNSIgeT0iLTIxMiI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDE2MjEsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI4IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzMiIHg9IjM4OSIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMjkiIHg9Ijg1OSIgeT0iMCI+PC91c2U+CjwvZz4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpTWjEtN0QiIHg9IjM0NTMiIHk9Ii0xIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTNEIiB4PSIxMzkxNSIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMzAiIHg9IjE0OTcxIiB5PSIwIj48L3VzZT4KPC9nPgo8L3N2Zz4=)

因为从开始状态 到终止状态

的样本路径上的总奖励根据定义是对所有这些路径的期望总奖励的无偏估计。因此,来自

个独立样本路径的估计平均值也是无偏的。

证明:

对于单次试验而言,首次访问MC方法是无偏的,由(1)得:

因为 次试验后的估计值

是

个独立估计样本的平均值,每个估计值都是无偏的,所以

次试验估计也是无偏的。

定理4 每次访问MC方法是有偏的,次试验后,

(

时每次访问MC方法变为无偏的)

证明:

对于单次试验而言,每次访问MC方法的偏差是:

那么, 。

在 次试验后计算偏差有点复杂,需要用组合数学

的形式表示

。我们可以把

看作是将

分解成

个非负整数的不同方式的个数——其次序被认为是重要的。因此得到,

。进一步假设

是可以获得从

到

的不同方式的数量——可以忽略顺序。注意,

。我们使用上标来区分来自不同试验的奖励,例如,

指的是在第2次试验中第

次和

次访问

之间收到的总的随机奖励。

又,

(2)

以及,

所以得到,

因此 。这也证明了每次访问MC方法在

时是无偏的。

给出(2)的证明:

将 定义为

平方因子的所有因子分解的总和:

存在以下事实:

fact 1:

fact 2:

fact 3:

fact 4:

fact 3和fact 4暗示着,

证明一下:

使用fact 1、fact 2、fact 3,我们可以证明 是递归的解,

因此证明了,

定理5 首次访问MC方法的方差为![[公式]](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjYxLjU2ZXgiIGhlaWdodD0iNy41MDlleCIgc3R5bGU9ImZvbnQtc2l6ZTogMTVweDsgdmVydGljYWwtYWxpZ246IC0zLjE3MWV4OyIgdmlld0JveD0iMCAtMTg2Ny43IDI2NTA1IDMyMzMuMiIgcm9sZT0iaW1nIiBmb2N1c2FibGU9ImZhbHNlIiB4bWxucz0iaHR0cDovL3d3dy53My5vcmcvMjAwMC9zdmciPgo8ZGVmcz4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTU2IiBkPSJNMTE0IDYyMFExMTMgNjIxIDExMCA2MjRUMTA3IDYyN1QxMDMgNjMwVDk4IDYzMlQ5MSA2MzRUODAgNjM1VDY3IDYzNlQ0OCA2MzdIMTlWNjgzSDI4UTQ2IDY4MCAxNTIgNjgwUTI3MyA2ODAgMjk0IDY4M0gzMDVWNjM3SDI4NFEyMjMgNjM0IDIyMyA2MjBRMjIzIDYxOCAzMTMgMzcyVDQwNCAxMjZMNDkwIDM1OFE1NzUgNTg4IDU3NSA1OTdRNTc1IDYxNiA1NTQgNjI2VDUwOCA2MzdINTAzVjY4M0g1MTJRNTI3IDY4MCA2MjcgNjgwUTcxOCA2ODAgNzI0IDY4M0g3MzBWNjM3SDcyM1E2NDggNjM3IDYyNyA1OTZRNjI3IDU5NSA1MTUgMjkxVDQwMSAtMTRRMzk2IC0yMiAzODIgLTIySDM3NEgzNjdRMzUzIC0yMiAzNDggLTE0UTM0NiAtMTIgMjMxIDMwM1ExMTQgNjE3IDExNCA2MjBaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi02MSIgZD0iTTEzNyAzMDVUMTE1IDMwNVQ3OCAzMjBUNjMgMzU5UTYzIDM5NCA5NyA0MjFUMjE4IDQ0OFEyOTEgNDQ4IDMzNiA0MTZUMzk2IDM0MFE0MDEgMzI2IDQwMSAzMDlUNDAyIDE5NFYxMjRRNDAyIDc2IDQwNyA1OFQ0MjggNDBRNDQzIDQwIDQ0OCA1NlQ0NTMgMTA5VjE0NUg0OTNWMTA2UTQ5MiA2NiA0OTAgNTlRNDgxIDI5IDQ1NSAxMlQ0MDAgLTZUMzUzIDEyVDMyOSA1NFY1OEwzMjcgNTVRMzI1IDUyIDMyMiA0OVQzMTQgNDBUMzAyIDI5VDI4NyAxN1QyNjkgNlQyNDcgLTJUMjIxIC04VDE5MCAtMTFRMTMwIC0xMSA4MiAyMFQzNCAxMDdRMzQgMTI4IDQxIDE0N1Q2OCAxODhUMTE2IDIyNVQxOTQgMjUzVDMwNCAyNjhIMzE4VjI5MFEzMTggMzI0IDMxMiAzNDBRMjkwIDQxMSAyMTUgNDExUTE5NyA0MTEgMTgxIDQxMFQxNTYgNDA2VDE0OCA0MDNRMTcwIDM4OCAxNzAgMzU5UTE3MCAzMzQgMTU0IDMyMFpNMTI2IDEwNlExMjYgNzUgMTUwIDUxVDIwOSAyNlEyNDcgMjYgMjc2IDQ5VDMxNSAxMDlRMzE3IDExNiAzMTggMTc1UTMxOCAyMzMgMzE3IDIzM1EzMDkgMjMzIDI5NiAyMzJUMjUxIDIyM1QxOTMgMjAzVDE0NyAxNjZUMTI2IDEwNloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTcyIiBkPSJNMzYgNDZINTBRODkgNDYgOTcgNjBWNjhROTcgNzcgOTcgOTFUOTggMTIyVDk4IDE2MVQ5OCAyMDNROTggMjM0IDk4IDI2OVQ5OCAzMjhMOTcgMzUxUTk0IDM3MCA4MyAzNzZUMzggMzg1SDIwVjQwOFEyMCA0MzEgMjIgNDMxTDMyIDQzMlE0MiA0MzMgNjAgNDM0VDk2IDQzNlExMTIgNDM3IDEzMSA0MzhUMTYwIDQ0MVQxNzEgNDQySDE3NFYzNzNRMjEzIDQ0MSAyNzEgNDQxSDI3N1EzMjIgNDQxIDM0MyA0MTlUMzY0IDM3M1EzNjQgMzUyIDM1MSAzMzdUMzEzIDMyMlEyODggMzIyIDI3NiAzMzhUMjYzIDM3MlEyNjMgMzgxIDI2NSAzODhUMjcwIDQwMFQyNzMgNDA1UTI3MSA0MDcgMjUwIDQwMVEyMzQgMzkzIDIyNiAzODZRMTc5IDM0MSAxNzkgMjA3VjE1NFExNzkgMTQxIDE3OSAxMjdUMTc5IDEwMVQxODAgODFUMTgwIDY2VjYxUTE4MSA1OSAxODMgNTdUMTg4IDU0VDE5MyA1MVQyMDAgNDlUMjA3IDQ4VDIxNiA0N1QyMjUgNDdUMjM1IDQ2VDI0NSA0NkgyNzZWMEgyNjdRMjQ5IDMgMTQwIDNRMzcgMyAyOCAwSDIwVjQ2SDM2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTQ2IiBkPSJNNDggMVEzMSAxIDMxIDExUTMxIDEzIDM0IDI1UTM4IDQxIDQyIDQzVDY1IDQ2UTkyIDQ2IDEyNSA0OVExMzkgNTIgMTQ0IDYxUTE0NiA2NiAyMTUgMzQyVDI4NSA2MjJRMjg1IDYyOSAyODEgNjI5UTI3MyA2MzIgMjI4IDYzNEgxOTdRMTkxIDY0MCAxOTEgNjQyVDE5MyA2NTlRMTk3IDY3NiAyMDMgNjgwSDc0MlE3NDkgNjc2IDc0OSA2NjlRNzQ5IDY2NCA3MzYgNTU3VDcyMiA0NDdRNzIwIDQ0MCA3MDIgNDQwSDY5MFE2ODMgNDQ1IDY4MyA0NTNRNjgzIDQ1NCA2ODYgNDc3VDY4OSA1MzBRNjg5IDU2MCA2ODIgNTc5VDY2MyA2MTBUNjI2IDYyNlQ1NzUgNjMzVDUwMyA2MzRINDgwUTM5OCA2MzMgMzkzIDYzMVEzODggNjI5IDM4NiA2MjNRMzg1IDYyMiAzNTIgNDkyTDMyMCAzNjNIMzc1UTM3OCAzNjMgMzk4IDM2M1Q0MjYgMzY0VDQ0OCAzNjdUNDcyIDM3NFQ0ODkgMzg2UTUwMiAzOTggNTExIDQxOVQ1MjQgNDU3VDUyOSA0NzVRNTMyIDQ4MCA1NDggNDgwSDU2MFE1NjcgNDc1IDU2NyA0NzBRNTY3IDQ2NyA1MzYgMzM5VDUwMiAyMDdRNTAwIDIwMCA0ODIgMjAwSDQ3MFE0NjMgMjA2IDQ2MyAyMTJRNDYzIDIxNSA0NjggMjM0VDQ3MyAyNzRRNDczIDMwMyA0NTMgMzEwVDM2NCAzMTdIMzA5TDI3NyAxOTBRMjQ1IDY2IDI0NSA2MFEyNDUgNDYgMzM0IDQ2SDM1OVEzNjUgNDAgMzY1IDM5VDM2MyAxOVEzNTkgNiAzNTMgMEgzMzZRMjk1IDIgMTg1IDJRMTIwIDIgODYgMlQ0OCAxWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTZFIiBkPSJNMjEgMjg3UTIyIDI5MyAyNCAzMDNUMzYgMzQxVDU2IDM4OFQ4OSA0MjVUMTM1IDQ0MlExNzEgNDQyIDE5NSA0MjRUMjI1IDM5MFQyMzEgMzY5UTIzMSAzNjcgMjMyIDM2N0wyNDMgMzc4UTMwNCA0NDIgMzgyIDQ0MlE0MzYgNDQyIDQ2OSA0MTVUNTAzIDMzNlQ0NjUgMTc5VDQyNyA1MlE0MjcgMjYgNDQ0IDI2UTQ1MCAyNiA0NTMgMjdRNDgyIDMyIDUwNSA2NVQ1NDAgMTQ1UTU0MiAxNTMgNTYwIDE1M1E1ODAgMTUzIDU4MCAxNDVRNTgwIDE0NCA1NzYgMTMwUTU2OCAxMDEgNTU0IDczVDUwOCAxN1Q0MzkgLTEwUTM5MiAtMTAgMzcxIDE3VDM1MCA3M1EzNTAgOTIgMzg2IDE5M1Q0MjMgMzQ1UTQyMyA0MDQgMzc5IDQwNEgzNzRRMjg4IDQwNCAyMjkgMzAzTDIyMiAyOTFMMTg5IDE1N1ExNTYgMjYgMTUxIDE2UTEzOCAtMTEgMTA4IC0xMVE5NSAtMTEgODcgLTVUNzYgN1Q3NCAxN1E3NCAzMCAxMTIgMTgwVDE1MiAzNDNRMTUzIDM0OCAxNTMgMzY2UTE1MyA0MDUgMTI5IDQwNVE5MSA0MDUgNjYgMzA1UTYwIDI4NSA2MCAyODRRNTggMjc4IDQxIDI3OEgyN1EyMSAyODQgMjEgMjg3WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tMjgiIGQ9Ik05NCAyNTBROTQgMzE5IDEwNCAzODFUMTI3IDQ4OFQxNjQgNTc2VDIwMiA2NDNUMjQ0IDY5NVQyNzcgNzI5VDMwMiA3NTBIMzE1SDMxOVEzMzMgNzUwIDMzMyA3NDFRMzMzIDczOCAzMTYgNzIwVDI3NSA2NjdUMjI2IDU4MVQxODQgNDQzVDE2NyAyNTBUMTg0IDU4VDIyNSAtODFUMjc0IC0xNjdUMzE2IC0yMjBUMzMzIC0yNDFRMzMzIC0yNTAgMzE4IC0yNTBIMzE1SDMwMkwyNzQgLTIyNlExODAgLTE0MSAxMzcgLTE0VDk0IDI1MFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS03MyIgZD0iTTEzMSAyODlRMTMxIDMyMSAxNDcgMzU0VDIwMyA0MTVUMzAwIDQ0MlEzNjIgNDQyIDM5MCA0MTVUNDE5IDM1NVE0MTkgMzIzIDQwMiAzMDhUMzY0IDI5MlEzNTEgMjkyIDM0MCAzMDBUMzI4IDMyNlEzMjggMzQyIDMzNyAzNTRUMzU0IDM3MlQzNjcgMzc4UTM2OCAzNzggMzY4IDM3OVEzNjggMzgyIDM2MSAzODhUMzM2IDM5OVQyOTcgNDA1UTI0OSA0MDUgMjI3IDM3OVQyMDQgMzI2UTIwNCAzMDEgMjIzIDI5MVQyNzggMjc0VDMzMCAyNTlRMzk2IDIzMCAzOTYgMTYzUTM5NiAxMzUgMzg1IDEwN1QzNTIgNTFUMjg5IDdUMTk1IC0xMFExMTggLTEwIDg2IDE5VDUzIDg3UTUzIDEyNiA3NCAxNDNUMTE4IDE2MFExMzMgMTYwIDE0NiAxNTFUMTYwIDEyMFExNjAgOTQgMTQyIDc2VDExMSA1OFExMDkgNTcgMTA4IDU3VDEwNyA1NVExMDggNTIgMTE1IDQ3VDE0NiAzNFQyMDEgMjdRMjM3IDI3IDI2MyAzOFQzMDEgNjZUMzE4IDk3VDMyMyAxMjJRMzIzIDE1MCAzMDIgMTY0VDI1NCAxODFUMTk1IDE5NlQxNDggMjMxUTEzMSAyNTYgMTMxIDI4OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTI5IiBkPSJNNjAgNzQ5TDY0IDc1MFE2OSA3NTAgNzQgNzUwSDg2TDExNCA3MjZRMjA4IDY0MSAyNTEgNTE0VDI5NCAyNTBRMjk0IDE4MiAyODQgMTE5VDI2MSAxMlQyMjQgLTc2VDE4NiAtMTQzVDE0NSAtMTk0VDExMyAtMjI3VDkwIC0yNDZRODcgLTI0OSA4NiAtMjUwSDc0UTY2IC0yNTAgNjMgLTI1MFQ1OCAtMjQ3VDU1IC0yMzhRNTYgLTIzNyA2NiAtMjI1UTIyMSAtNjQgMjIxIDI1MFQ2NiA3MjVRNTYgNzM3IDU1IDczOFE1NSA3NDYgNjAgNzQ5WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tM0QiIGQ9Ik01NiAzNDdRNTYgMzYwIDcwIDM2N0g3MDdRNzIyIDM1OSA3MjIgMzQ3UTcyMiAzMzYgNzA4IDMyOEwzOTAgMzI3SDcyUTU2IDMzMiA1NiAzNDdaTTU2IDE1M1E1NiAxNjggNzIgMTczSDcwOFE3MjIgMTYzIDcyMiAxNTNRNzIyIDE0MCA3MDcgMTMzSDcwUTU2IDE0MCA1NiAxNTNaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi0zMSIgZD0iTTIxMyA1NzhMMjAwIDU3M1ExODYgNTY4IDE2MCA1NjNUMTAyIDU1Nkg4M1Y2MDJIMTAyUTE0OSA2MDQgMTg5IDYxN1QyNDUgNjQxVDI3MyA2NjNRMjc1IDY2NiAyODUgNjY2UTI5NCA2NjYgMzAyIDY2MFYzNjFMMzAzIDYxUTMxMCA1NCAzMTUgNTJUMzM5IDQ4VDQwMSA0Nkg0MjdWMEg0MTZRMzk1IDMgMjU3IDNRMTIxIDMgMTAwIDBIODhWNDZIMTE0UTEzNiA0NiAxNTIgNDZUMTc3IDQ3VDE5MyA1MFQyMDEgNTJUMjA3IDU3VDIxMyA2MVY1NzhaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi01QiIgZD0iTTExOCAtMjUwVjc1MEgyNTVWNzEwSDE1OFYtMjEwSDI1NVYtMjUwSDExOFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS03MiIgZD0iTTIxIDI4N1EyMiAyOTAgMjMgMjk1VDI4IDMxN1QzOCAzNDhUNTMgMzgxVDczIDQxMVQ5OSA0MzNUMTMyIDQ0MlExNjEgNDQyIDE4MyA0MzBUMjE0IDQwOFQyMjUgMzg4UTIyNyAzODIgMjI4IDM4MlQyMzYgMzg5UTI4NCA0NDEgMzQ3IDQ0MUgzNTBRMzk4IDQ0MSA0MjIgNDAwUTQzMCAzODEgNDMwIDM2M1E0MzAgMzMzIDQxNyAzMTVUMzkxIDI5MlQzNjYgMjg4UTM0NiAyODggMzM0IDI5OVQzMjIgMzI4UTMyMiAzNzYgMzc4IDM5MlEzNTYgNDA1IDM0MiA0MDVRMjg2IDQwNSAyMzkgMzMxUTIyOSAzMTUgMjI0IDI5OFQxOTAgMTY1UTE1NiAyNSAxNTEgMTZRMTM4IC0xMSAxMDggLTExUTk1IC0xMSA4NyAtNVQ3NiA3VDc0IDE3UTc0IDMwIDExNCAxODlUMTU0IDM2NlExNTQgNDA1IDEyOCA0MDVRMTA3IDQwNSA5MiAzNzdUNjggMzE2VDU3IDI4MFE1NSAyNzggNDEgMjc4SDI3UTIxIDI4NCAyMSAyODdaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFUSEktNTQiIGQ9Ik00MCA0MzdRMjEgNDM3IDIxIDQ0NVEyMSA0NTAgMzcgNTAxVDcxIDYwMkw4OCA2NTFROTMgNjY5IDEwMSA2NzdINTY5SDY1OVE2OTEgNjc3IDY5NyA2NzZUNzA0IDY2N1E3MDQgNjYxIDY4NyA1NTNUNjY4IDQ0NFE2NjggNDM3IDY0OSA0MzdRNjQwIDQzNyA2MzcgNDM3VDYzMSA0NDJMNjI5IDQ0NVE2MjkgNDUxIDYzNSA0OTBUNjQxIDU1MVE2NDEgNTg2IDYyOCA2MDRUNTczIDYyOVE1NjggNjMwIDUxNSA2MzFRNDY5IDYzMSA0NTcgNjMwVDQzOSA2MjJRNDM4IDYyMSAzNjggMzQzVDI5OCA2MFEyOTggNDggMzg2IDQ2UTQxOCA0NiA0MjcgNDVUNDM2IDM2UTQzNiAzMSA0MzMgMjJRNDI5IDQgNDI0IDFMNDIyIDBRNDE5IDAgNDE1IDBRNDEwIDAgMzYzIDFUMjI4IDJROTkgMiA2NCAwSDQ5UTQzIDYgNDMgOVQ0NSAyN1E0OSA0MCA1NSA0Nkg4M0g5NFExNzQgNDYgMTg5IDU1UTE5MCA1NiAxOTEgNTZRMTk2IDU5IDIwMSA3NlQyNDEgMjMzUTI1OCAzMDEgMjY5IDM0NFEzMzkgNjE5IDMzOSA2MjVRMzM5IDYzMCAzMTAgNjMwSDI3OVEyMTIgNjMwIDE5MSA2MjRRMTQ2IDYxNCAxMjEgNTgzVDY3IDQ2N1E2MCA0NDUgNTcgNDQxVDQzIDQzN0g0MFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTJCIiBkPSJNNTYgMjM3VDU2IDI1MFQ3MCAyNzBIMzY5VjQyMEwzNzAgNTcwUTM4MCA1ODMgMzg5IDU4M1E0MDIgNTgzIDQwOSA1NjhWMjcwSDcwN1E3MjIgMjYyIDcyMiAyNTBUNzA3IDIzMEg0MDlWLTY4UTQwMSAtODIgMzkxIC04MkgzODlIMzg3UTM3NSAtODIgMzY5IC02OFYyMzBINzBRNTYgMjM3IDU2IDI1MFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS01MCIgZD0iTTI4NyA2MjhRMjg3IDYzNSAyMzAgNjM3UTIwNiA2MzcgMTk5IDYzOFQxOTIgNjQ4UTE5MiA2NDkgMTk0IDY1OVEyMDAgNjc5IDIwMyA2ODFUMzk3IDY4M1E1ODcgNjgyIDYwMCA2ODBRNjY0IDY2OSA3MDcgNjMxVDc1MSA1MzBRNzUxIDQ1MyA2ODUgMzg5UTYxNiAzMjEgNTA3IDMwM1E1MDAgMzAyIDQwMiAzMDFIMzA3TDI3NyAxODJRMjQ3IDY2IDI0NyA1OVEyNDcgNTUgMjQ4IDU0VDI1NSA1MFQyNzIgNDhUMzA1IDQ2SDMzNlEzNDIgMzcgMzQyIDM1UTM0MiAxOSAzMzUgNVEzMzAgMCAzMTkgMFEzMTYgMCAyODIgMVQxODIgMlExMjAgMiA4NyAyVDUxIDFRMzMgMSAzMyAxMVEzMyAxMyAzNiAyNVE0MCA0MSA0NCA0M1Q2NyA0NlE5NCA0NiAxMjcgNDlRMTQxIDUyIDE0NiA2MVExNDkgNjUgMjE4IDMzOVQyODcgNjI4Wk02NDUgNTU0UTY0NSA1NjcgNjQzIDU3NVQ2MzQgNTk3VDYwOSA2MTlUNTYwIDYzNVE1NTMgNjM2IDQ4MCA2MzdRNDYzIDYzNyA0NDUgNjM3VDQxNiA2MzZUNDA0IDYzNlEzOTEgNjM1IDM4NiA2MjdRMzg0IDYyMSAzNjcgNTUwVDMzMiA0MTJUMzE0IDM0NFEzMTQgMzQyIDM5NSAzNDJINDA3SDQzMFE1NDIgMzQyIDU5MCAzOTJRNjE3IDQxOSA2MzEgNDcxVDY0NSA1NTRaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi0zMiIgZD0iTTEwOSA0MjlRODIgNDI5IDY2IDQ0N1Q1MCA0OTFRNTAgNTYyIDEwMyA2MTRUMjM1IDY2NlEzMjYgNjY2IDM4NyA2MTBUNDQ5IDQ2NVE0NDkgNDIyIDQyOSAzODNUMzgxIDMxNVQzMDEgMjQxUTI2NSAyMTAgMjAxIDE0OUwxNDIgOTNMMjE4IDkyUTM3NSA5MiAzODUgOTdRMzkyIDk5IDQwOSAxODZWMTg5SDQ0OVYxODZRNDQ4IDE4MyA0MzYgOTVUNDIxIDNWMEg1MFYxOVYzMVE1MCAzOCA1NiA0NlQ4NiA4MVExMTUgMTEzIDEzNiAxMzdRMTQ1IDE0NyAxNzAgMTc0VDIwNCAyMTFUMjMzIDI0NFQyNjEgMjc4VDI4NCAzMDhUMzA1IDM0MFQzMjAgMzY5VDMzMyA0MDFUMzQwIDQzMVQzNDMgNDY0UTM0MyA1MjcgMzA5IDU3M1QyMTIgNjE5UTE3OSA2MTkgMTU0IDYwMlQxMTkgNTY5VDEwOSA1NTBRMTA5IDU0OSAxMTQgNTQ5UTEzMiA1NDkgMTUxIDUzNVQxNzAgNDg5UTE3MCA0NjQgMTU0IDQ0N1QxMDkgNDI5WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTUyIiBkPSJNMjMwIDYzN1EyMDMgNjM3IDE5OCA2MzhUMTkzIDY0OVExOTMgNjc2IDIwNCA2ODJRMjA2IDY4MyAzNzggNjgzUTU1MCA2ODIgNTY0IDY4MFE2MjAgNjcyIDY1OCA2NTJUNzEyIDYwNlQ3MzMgNTYzVDczOSA1MjlRNzM5IDQ4NCA3MTAgNDQ1VDY0MyAzODVUNTc2IDM1MVQ1MzggMzM4TDU0NSAzMzNRNjEyIDI5NSA2MTIgMjIzUTYxMiAyMTIgNjA3IDE2MlQ2MDIgODBWNzFRNjAyIDUzIDYwMyA0M1Q2MTQgMjVUNjQwIDE2UTY2OCAxNiA2ODYgMzhUNzEyIDg1UTcxNyA5OSA3MjAgMTAyVDczNSAxMDVRNzU1IDEwNSA3NTUgOTNRNzU1IDc1IDczMSAzNlE2OTMgLTIxIDY0MSAtMjFINjMyUTU3MSAtMjEgNTMxIDRUNDg3IDgyUTQ4NyAxMDkgNTAyIDE2NlQ1MTcgMjM5UTUxNyAyOTAgNDc0IDMxM1E0NTkgMzIwIDQ0OSAzMjFUMzc4IDMyM0gzMDlMMjc3IDE5M1EyNDQgNjEgMjQ0IDU5UTI0NCA1NSAyNDUgNTRUMjUyIDUwVDI2OSA0OFQzMDIgNDZIMzMzUTMzOSAzOCAzMzkgMzdUMzM2IDE5UTMzMiA2IDMyNiAwSDMxMVEyNzUgMiAxODAgMlExNDYgMiAxMTcgMlQ3MSAyVDUwIDFRMzMgMSAzMyAxMFEzMyAxMiAzNiAyNFE0MSA0MyA0NiA0NVE1MCA0NiA2MSA0Nkg2N1E5NCA0NiAxMjcgNDlRMTQxIDUyIDE0NiA2MVExNDkgNjUgMjE4IDMzOVQyODcgNjI4UTI4NyA2MzUgMjMwIDYzN1pNNjMwIDU1NFE2MzAgNTg2IDYwOSA2MDhUNTIzIDYzNlE1MjEgNjM2IDUwMCA2MzZUNDYyIDYzN0g0NDBRMzkzIDYzNyAzODYgNjI3UTM4NSA2MjQgMzUyIDQ5NFQzMTkgMzYxUTMxOSAzNjAgMzg4IDM2MFE0NjYgMzYxIDQ5MiAzNjdRNTU2IDM3NyA1OTIgNDI2UTYwOCA0NDkgNjE5IDQ4NlQ2MzAgNTU0WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNUQiIGQ9Ik0yMiA3MTBWNzUwSDE1OVYtMjUwSDIyVi0yMTBIMTE5VjcxMEgyMloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpTWjQtNUIiIGQ9Ik0yNjkgLTEyNDlWMTc1MEg1NzdWMTY3N0gzNDJWLTExNzZINTc3Vi0xMjQ5SDI2OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpTWjQtNUQiIGQ9Ik01IDE2NzdWMTc1MEgzMTNWLTEyNDlINVYtMTE3NkgyNDBWMTY3N0g1WiI+PC9wYXRoPgo8L2RlZnM+CjxnIHN0cm9rZT0iY3VycmVudENvbG9yIiBmaWxsPSJjdXJyZW50Q29sb3IiIHN0cm9rZS13aWR0aD0iMCIgdHJhbnNmb3JtPSJtYXRyaXgoMSAwIDAgLTEgMCAwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNTYiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTYxIiB4PSI3NTAiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTcyIiB4PSIxMjUxIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTQ2IiB4PSIyMzI0IiB5PSI1ODEiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNkUiIHg9IjIzMjQiIHk9Ii0zNTAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgyNDQwLDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIzODkiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSI4NTkiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tM0QiIHg9IjM5NjYiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg0NzQ0LDApIj4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMzk3LDApIj4KPHJlY3Qgc3Ryb2tlPSJub25lIiB3aWR0aD0iMzgwOCIgaGVpZ2h0PSI2MCIgeD0iMCIgeT0iMjIwIj48L3JlY3Q+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDYwLDc3MCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTU2Ij48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi02MSIgeD0iNzUwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi03MiIgeD0iMTI1MSIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS00NiIgeD0iMjMyNCIgeT0iNTgxIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMzEiIHg9IjIzMjQiIHk9Ii0zNTAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgyNDQwLDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIzODkiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSI4NTkiIHk9IjAiPjwvdXNlPgo8L2c+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNkUiIHg9IjE2MDQiIHk9Ii02ODYiPjwvdXNlPgo8L2c+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0zRCIgeD0iOTM0OSIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDEwMTI3LDApIj4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMzk3LDApIj4KPHJlY3Qgc3Ryb2tlPSJub25lIiB3aWR0aD0iNzIwIiBoZWlnaHQ9IjYwIiB4PSIwIiB5PSIyMjAiPjwvcmVjdD4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0zMSIgeD0iMTEwIiB5PSI2NzYiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS02RSIgeD0iNjAiIHk9Ii02ODYiPjwvdXNlPgo8L2c+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMTEzNjUsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpTWjQtNUIiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg1ODMsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTU2Ij48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi02MSIgeD0iNzUwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi03MiIgeD0iMTI1MSIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDE4MTAsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI4IiB4PSIwIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMzg5LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzIiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTQiIHg9IjYzOCIgeT0iLTIxMyI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOSIgeD0iMTQzOSIgeT0iMCI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yQiIgeD0iMzg2MSIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDQ2MzksMCkiPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgzNDIsMCkiPgo8cmVjdCBzdHJva2U9Im5vbmUiIHdpZHRoPSIxMzYwIiBoZWlnaHQ9IjYwIiB4PSIwIiB5PSIyMjAiPjwvcmVjdD4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMTQzLDY3NykiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS01MCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS03MyIgeD0iOTA4IiB5PSItMjEzIj48L3VzZT4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg2MCwtNzA0KSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTUwIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTU0IiB4PSI5MDgiIHk9Ii0yMTMiPjwvdXNlPgo8L2c+CjwvZz4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg2NDYyLDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi01NiI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNjEiIHg9Ijc1MCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNzIiIHg9IjEyNTEiIHk9IjAiPjwvdXNlPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDgyNzIsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI4IiB4PSIwIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMzg5LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzIiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzMiIHg9IjYzOCIgeT0iLTIxMyI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOSIgeD0iMTI3MiIgeT0iMCI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yQiIgeD0iMTAxNTciIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxMDkzNSwwKSI+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDM0MiwwKSI+CjxyZWN0IHN0cm9rZT0ibm9uZSIgd2lkdGg9IjEzNjAiIGhlaWdodD0iNjAiIHg9IjAiIHk9IjIyMCI+PC9yZWN0Pgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxNDMsNjc3KSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTUwIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSI5MDgiIHk9Ii0yMTMiPjwvdXNlPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDYwLC04MzcpIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTAiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0zMiIgeD0iMTEwOSIgeT0iNDg4Ij48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTU0IiB4PSI5MDgiIHk9Ii00NDYiPjwvdXNlPgo8L2c+CjwvZz4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxMjc1OCwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTUyIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMzIiIHg9IjEwNzQiIHk9IjQ4OCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS03MyIgeD0iMTA3NCIgeT0iLTIxMiI+PC91c2U+CjwvZz4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpTWjQtNUQiIHg9IjE0NTU1IiB5PSItMSI+PC91c2U+CjwvZz4KPC9nPgo8L3N2Zz4=)

证明:

我们首先计算一次试验得到的序列 的方差,

第一项是由于对状态 的重访次数的变化引起的方差,第二项是由于随机奖励引起的方差。在

次试验后首次访问MC方法估计是

次独立试验样本的平均值,因此,

。

定理6 首次访问MC方法的MSE是![[公式]](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9Ijc3LjA1OWV4IiBoZWlnaHQ9IjcuNTA5ZXgiIHN0eWxlPSJmb250LXNpemU6IDE1cHg7IHZlcnRpY2FsLWFsaWduOiAtMy4xNzFleDsiIHZpZXdCb3g9IjAgLTE4NjcuNyAzMzE3OCAzMjMzLjIiIHJvbGU9ImltZyIgZm9jdXNhYmxlPSJmYWxzZSIgeG1sbnM9Imh0dHA6Ly93d3cudzMub3JnLzIwMDAvc3ZnIj4KPGRlZnM+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi00RCIgZD0iTTEzMiA2MjJRMTI1IDYyOSAxMjEgNjMxVDEwNSA2MzRUNjIgNjM3SDI5VjY4M0gxMzVRMjIxIDY4MyAyMzIgNjgyVDI0OSA2NzVRMjUwIDY3NCAzNTQgMzk4TDQ1OCAxMjRMNTYyIDM5OFE2NjYgNjc0IDY2OCA2NzVRNjcxIDY4MSA2ODMgNjgyVDc4MSA2ODNIODg3VjYzN0g4NTRRODE0IDYzNiA4MDMgNjM0VDc4NSA2MjJWNjFRNzkxIDUxIDgwMiA0OVQ4NTQgNDZIODg3VjBIODc2UTg1NSAzIDczNiAzUTYwNSAzIDU5NiAwSDU4NVY0Nkg2MThRNjYwIDQ3IDY2OSA0OVQ2ODggNjFWMzQ3UTY4OCA0MjQgNjg4IDQ2MVQ2ODggNTQ2VDY4OCA2MTNMNjg3IDYzMlE0NTQgMTQgNDUwIDdRNDQ2IDEgNDMwIDFUNDEwIDdRNDA5IDkgMjkyIDMxNkwxNzYgNjI0VjYwNlExNzUgNTg4IDE3NSA1NDNUMTc1IDQ2M1QxNzUgMzU2TDE3NiA4NlExODcgNTAgMjYxIDQ2SDI3OFYwSDI2OVEyNTQgMyAxNTQgM1E1MiAzIDM3IDBIMjlWNDZINDZRNzggNDggOTggNTZUMTIyIDY5VDEzMiA4NlY2MjJaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi01MyIgZD0iTTU1IDUwN1E1NSA1OTAgMTEyIDY0N1QyNDMgNzA0SDI1N1EzNDIgNzA0IDQwNSA2NDFMNDI2IDY3MlE0MzEgNjc5IDQzNiA2ODdUNDQ2IDcwMEw0NDkgNzA0UTQ1MCA3MDQgNDUzIDcwNFQ0NTkgNzA1SDQ2M1E0NjYgNzA1IDQ3MiA2OTlWNDYyTDQ2NiA0NTZINDQ4UTQzNyA0NTYgNDM1IDQ1OVQ0MzAgNDc5UTQxMyA2MDUgMzI5IDY0NlEyOTIgNjYyIDI1NCA2NjJRMjAxIDY2MiAxNjggNjI2VDEzNSA1NDJRMTM1IDUwOCAxNTIgNDgwVDIwMCA0MzVRMjEwIDQzMSAyODYgNDEyVDM3MCAzODlRNDI3IDM2NyA0NjMgMzE0VDUwMCAxOTFRNTAwIDExMCA0NDggNDVUMzAxIC0yMVEyNDUgLTIxIDIwMSAtNFQxNDAgMjdMMTIyIDQxUTExOCAzNiAxMDcgMjFUODcgLTdUNzggLTIxUTc2IC0yMiA2OCAtMjJINjRRNjEgLTIyIDU1IC0xNlYxMDFRNTUgMjIwIDU2IDIyMlE1OCAyMjcgNzYgMjI3SDg5UTk1IDIyMSA5NSAyMTRROTUgMTgyIDEwNSAxNTFUMTM5IDkwVDIwNSA0MlQzMDUgMjRRMzUyIDI0IDM4NiA2MlQ0MjAgMTU1UTQyMCAxOTggMzk4IDIzM1QzNDAgMjgxUTI4NCAyOTUgMjY2IDMwMFEyNjEgMzAxIDIzOSAzMDZUMjA2IDMxNFQxNzQgMzI1VDE0MSAzNDNUMTEyIDM2N1Q4NSA0MDJRNTUgNDUxIDU1IDUwN1oiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTQ1IiBkPSJNMTI4IDYxOVExMjEgNjI2IDExNyA2MjhUMTAxIDYzMVQ1OCA2MzRIMjVWNjgwSDU5N1Y2NzZRNTk5IDY3MCA2MTEgNTYwVDYyNSA0NDRWNDQwSDU4NVY0NDRRNTg0IDQ0NyA1ODIgNDY1UTU3OCA1MDAgNTcwIDUyNlQ1NTMgNTcxVDUyOCA2MDFUNDk4IDYxOVQ0NTcgNjI5VDQxMSA2MzNUMzUzIDYzNFEyNjYgNjM0IDI1MSA2MzNUMjMzIDYyMlEyMzMgNjIyIDIzMyA2MjFRMjMyIDYxOSAyMzIgNDk3VjM3NkgyODZRMzU5IDM3OCAzNzcgMzg1UTQxMyA0MDEgNDE2IDQ2OVE0MTYgNDcxIDQxNiA0NzNWNDkzSDQ1NlYyMTNINDE2VjIzM1E0MTUgMjY4IDQwOCAyODhUMzgzIDMxN1QzNDkgMzI4VDI5NyAzMzBRMjkwIDMzMCAyODYgMzMwSDIzMlYxOTZWMTE0UTIzMiA1NyAyMzcgNTJRMjQzIDQ3IDI4OSA0N0gzNDBIMzkxUTQyOCA0NyA0NTIgNTBUNTA1IDYyVDU1MiA5MlQ1ODQgMTQ2UTU5NCAxNzIgNTk5IDIwMFQ2MDcgMjQ3VDYxMiAyNzBWMjczSDY1MlYyNzBRNjUxIDI2NyA2MzIgMTM3VDYxMCAzVjBIMjVWNDZINThRMTAwIDQ3IDEwOSA0OVQxMjggNjFWNjE5WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTQ2IiBkPSJNNDggMVEzMSAxIDMxIDExUTMxIDEzIDM0IDI1UTM4IDQxIDQyIDQzVDY1IDQ2UTkyIDQ2IDEyNSA0OVExMzkgNTIgMTQ0IDYxUTE0NiA2NiAyMTUgMzQyVDI4NSA2MjJRMjg1IDYyOSAyODEgNjI5UTI3MyA2MzIgMjI4IDYzNEgxOTdRMTkxIDY0MCAxOTEgNjQyVDE5MyA2NTlRMTk3IDY3NiAyMDMgNjgwSDc0MlE3NDkgNjc2IDc0OSA2NjlRNzQ5IDY2NCA3MzYgNTU3VDcyMiA0NDdRNzIwIDQ0MCA3MDIgNDQwSDY5MFE2ODMgNDQ1IDY4MyA0NTNRNjgzIDQ1NCA2ODYgNDc3VDY4OSA1MzBRNjg5IDU2MCA2ODIgNTc5VDY2MyA2MTBUNjI2IDYyNlQ1NzUgNjMzVDUwMyA2MzRINDgwUTM5OCA2MzMgMzkzIDYzMVEzODggNjI5IDM4NiA2MjNRMzg1IDYyMiAzNTIgNDkyTDMyMCAzNjNIMzc1UTM3OCAzNjMgMzk4IDM2M1Q0MjYgMzY0VDQ0OCAzNjdUNDcyIDM3NFQ0ODkgMzg2UTUwMiAzOTggNTExIDQxOVQ1MjQgNDU3VDUyOSA0NzVRNTMyIDQ4MCA1NDggNDgwSDU2MFE1NjcgNDc1IDU2NyA0NzBRNTY3IDQ2NyA1MzYgMzM5VDUwMiAyMDdRNTAwIDIwMCA0ODIgMjAwSDQ3MFE0NjMgMjA2IDQ2MyAyMTJRNDYzIDIxNSA0NjggMjM0VDQ3MyAyNzRRNDczIDMwMyA0NTMgMzEwVDM2NCAzMTdIMzA5TDI3NyAxOTBRMjQ1IDY2IDI0NSA2MFEyNDUgNDYgMzM0IDQ2SDM1OVEzNjUgNDAgMzY1IDM5VDM2MyAxOVEzNTkgNiAzNTMgMEgzMzZRMjk1IDIgMTg1IDJRMTIwIDIgODYgMlQ0OCAxWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTZFIiBkPSJNMjEgMjg3UTIyIDI5MyAyNCAzMDNUMzYgMzQxVDU2IDM4OFQ4OSA0MjVUMTM1IDQ0MlExNzEgNDQyIDE5NSA0MjRUMjI1IDM5MFQyMzEgMzY5UTIzMSAzNjcgMjMyIDM2N0wyNDMgMzc4UTMwNCA0NDIgMzgyIDQ0MlE0MzYgNDQyIDQ2OSA0MTVUNTAzIDMzNlQ0NjUgMTc5VDQyNyA1MlE0MjcgMjYgNDQ0IDI2UTQ1MCAyNiA0NTMgMjdRNDgyIDMyIDUwNSA2NVQ1NDAgMTQ1UTU0MiAxNTMgNTYwIDE1M1E1ODAgMTUzIDU4MCAxNDVRNTgwIDE0NCA1NzYgMTMwUTU2OCAxMDEgNTU0IDczVDUwOCAxN1Q0MzkgLTEwUTM5MiAtMTAgMzcxIDE3VDM1MCA3M1EzNTAgOTIgMzg2IDE5M1Q0MjMgMzQ1UTQyMyA0MDQgMzc5IDQwNEgzNzRRMjg4IDQwNCAyMjkgMzAzTDIyMiAyOTFMMTg5IDE1N1ExNTYgMjYgMTUxIDE2UTEzOCAtMTEgMTA4IC0xMVE5NSAtMTEgODcgLTVUNzYgN1Q3NCAxN1E3NCAzMCAxMTIgMTgwVDE1MiAzNDNRMTUzIDM0OCAxNTMgMzY2UTE1MyA0MDUgMTI5IDQwNVE5MSA0MDUgNjYgMzA1UTYwIDI4NSA2MCAyODRRNTggMjc4IDQxIDI3OEgyN1EyMSAyODQgMjEgMjg3WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tMjgiIGQ9Ik05NCAyNTBROTQgMzE5IDEwNCAzODFUMTI3IDQ4OFQxNjQgNTc2VDIwMiA2NDNUMjQ0IDY5NVQyNzcgNzI5VDMwMiA3NTBIMzE1SDMxOVEzMzMgNzUwIDMzMyA3NDFRMzMzIDczOCAzMTYgNzIwVDI3NSA2NjdUMjI2IDU4MVQxODQgNDQzVDE2NyAyNTBUMTg0IDU4VDIyNSAtODFUMjc0IC0xNjdUMzE2IC0yMjBUMzMzIC0yNDFRMzMzIC0yNTAgMzE4IC0yNTBIMzE1SDMwMkwyNzQgLTIyNlExODAgLTE0MSAxMzcgLTE0VDk0IDI1MFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQVRISS03MyIgZD0iTTEzMSAyODlRMTMxIDMyMSAxNDcgMzU0VDIwMyA0MTVUMzAwIDQ0MlEzNjIgNDQyIDM5MCA0MTVUNDE5IDM1NVE0MTkgMzIzIDQwMiAzMDhUMzY0IDI5MlEzNTEgMjkyIDM0MCAzMDBUMzI4IDMyNlEzMjggMzQyIDMzNyAzNTRUMzU0IDM3MlQzNjcgMzc4UTM2OCAzNzggMzY4IDM3OVEzNjggMzgyIDM2MSAzODhUMzM2IDM5OVQyOTcgNDA1UTI0OSA0MDUgMjI3IDM3OVQyMDQgMzI2UTIwNCAzMDEgMjIzIDI5MVQyNzggMjc0VDMzMCAyNTlRMzk2IDIzMCAzOTYgMTYzUTM5NiAxMzUgMzg1IDEwN1QzNTIgNTFUMjg5IDdUMTk1IC0xMFExMTggLTEwIDg2IDE5VDUzIDg3UTUzIDEyNiA3NCAxNDNUMTE4IDE2MFExMzMgMTYwIDE0NiAxNTFUMTYwIDEyMFExNjAgOTQgMTQyIDc2VDExMSA1OFExMDkgNTcgMTA4IDU3VDEwNyA1NVExMDggNTIgMTE1IDQ3VDE0NiAzNFQyMDEgMjdRMjM3IDI3IDI2MyAzOFQzMDEgNjZUMzE4IDk3VDMyMyAxMjJRMzIzIDE1MCAzMDIgMTY0VDI1NCAxODFUMTk1IDE5NlQxNDggMjMxUTEzMSAyNTYgMTMxIDI4OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTI5IiBkPSJNNjAgNzQ5TDY0IDc1MFE2OSA3NTAgNzQgNzUwSDg2TDExNCA3MjZRMjA4IDY0MSAyNTEgNTE0VDI5NCAyNTBRMjk0IDE4MiAyODQgMTE5VDI2MSAxMlQyMjQgLTc2VDE4NiAtMTQzVDE0NSAtMTk0VDExMyAtMjI3VDkwIC0yNDZRODcgLTI0OSA4NiAtMjUwSDc0UTY2IC0yNTAgNjMgLTI1MFQ1OCAtMjQ3VDU1IC0yMzhRNTYgLTIzNyA2NiAtMjI1UTIyMSAtNjQgMjIxIDI1MFQ2NiA3MjVRNTYgNzM3IDU1IDczOFE1NSA3NDYgNjAgNzQ5WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tM0QiIGQ9Ik01NiAzNDdRNTYgMzYwIDcwIDM2N0g3MDdRNzIyIDM1OSA3MjIgMzQ3UTcyMiAzMzYgNzA4IDMyOEwzOTAgMzI3SDcyUTU2IDMzMiA1NiAzNDdaTTU2IDE1M1E1NiAxNjggNzIgMTczSDcwOFE3MjIgMTYzIDcyMiAxNTNRNzIyIDE0MCA3MDcgMTMzSDcwUTU2IDE0MCA1NiAxNTNaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi00MiIgZD0iTTEzMSA2MjJRMTI0IDYyOSAxMjAgNjMxVDEwNCA2MzRUNjEgNjM3SDI4VjY4M0gyMjlIMjY3SDM0NlE0MjMgNjgzIDQ1OSA2NzhUNTMxIDY1MVE1NzQgNjI3IDU5OSA1OTBUNjI0IDUxMlE2MjQgNDYxIDU4MyA0MTlUNDc2IDM2MEw0NjYgMzU3UTUzOSAzNDggNTk1IDMwMlQ2NTEgMTg3UTY1MSAxMTkgNjAwIDY3VDQ2OSAzUTQ1NiAxIDI0MiAwSDI4VjQ2SDYxUTEwMyA0NyAxMTIgNDlUMTMxIDYxVjYyMlpNNTExIDUxM1E1MTEgNTYwIDQ4NSA1OTRUNDE2IDYzNlE0MTUgNjM2IDQwMyA2MzZUMzcxIDYzNlQzMzMgNjM3UTI2NiA2MzcgMjUxIDYzNlQyMzIgNjI4UTIyOSA2MjQgMjI5IDQ5OVYzNzRIMzEyTDM5NiAzNzVMNDA2IDM3N1E0MTAgMzc4IDQxNyAzODBUNDQyIDM5M1Q0NzQgNDE3VDQ5OSA0NTZUNTExIDUxM1pNNTM3IDE4OFE1MzcgMjM5IDUwOSAyODJUNDMwIDMzNkwzMjkgMzM3SDIyOVYyMDBWMTE2UTIyOSA1NyAyMzQgNTJRMjQwIDQ3IDMzNCA0N0gzODNRNDI1IDQ3IDQ0MyA1M1E0ODYgNjcgNTExIDEwNFQ1MzcgMTg4WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNjkiIGQ9Ik02OSA2MDlRNjkgNjM3IDg3IDY1M1QxMzEgNjY5UTE1NCA2NjcgMTcxIDY1MlQxODggNjA5UTE4OCA1NzkgMTcxIDU2NFQxMjkgNTQ5UTEwNCA1NDkgODcgNTY0VDY5IDYwOVpNMjQ3IDBRMjMyIDMgMTQzIDNRMTMyIDMgMTA2IDNUNTYgMUwzNCAwSDI2VjQ2SDQyUTcwIDQ2IDkxIDQ5UTEwMCA1MyAxMDIgNjBUMTA0IDEwMlYyMDVWMjkzUTEwNCAzNDUgMTAyIDM1OVQ4OCAzNzhRNzQgMzg1IDQxIDM4NUgzMFY0MDhRMzAgNDMxIDMyIDQzMUw0MiA0MzJRNTIgNDMzIDcwIDQzNFQxMDYgNDM2UTEyMyA0MzcgMTQyIDQzOFQxNzEgNDQxVDE4MiA0NDJIMTg1VjYyUTE5MCA1MiAxOTcgNTBUMjMyIDQ2SDI1NVYwSDI0N1oiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTYxIiBkPSJNMTM3IDMwNVQxMTUgMzA1VDc4IDMyMFQ2MyAzNTlRNjMgMzk0IDk3IDQyMVQyMTggNDQ4UTI5MSA0NDggMzM2IDQxNlQzOTYgMzQwUTQwMSAzMjYgNDAxIDMwOVQ0MDIgMTk0VjEyNFE0MDIgNzYgNDA3IDU4VDQyOCA0MFE0NDMgNDAgNDQ4IDU2VDQ1MyAxMDlWMTQ1SDQ5M1YxMDZRNDkyIDY2IDQ5MCA1OVE0ODEgMjkgNDU1IDEyVDQwMCAtNlQzNTMgMTJUMzI5IDU0VjU4TDMyNyA1NVEzMjUgNTIgMzIyIDQ5VDMxNCA0MFQzMDIgMjlUMjg3IDE3VDI2OSA2VDI0NyAtMlQyMjEgLThUMTkwIC0xMVExMzAgLTExIDgyIDIwVDM0IDEwN1EzNCAxMjggNDEgMTQ3VDY4IDE4OFQxMTYgMjI1VDE5NCAyNTNUMzA0IDI2OEgzMThWMjkwUTMxOCAzMjQgMzEyIDM0MFEyOTAgNDExIDIxNSA0MTFRMTk3IDQxMSAxODEgNDEwVDE1NiA0MDZUMTQ4IDQwM1ExNzAgMzg4IDE3MCAzNTlRMTcwIDMzNCAxNTQgMzIwWk0xMjYgMTA2UTEyNiA3NSAxNTAgNTFUMjA5IDI2UTI0NyAyNiAyNzYgNDlUMzE1IDEwOVEzMTcgMTE2IDMxOCAxNzVRMzE4IDIzMyAzMTcgMjMzUTMwOSAyMzMgMjk2IDIzMlQyNTEgMjIzVDE5MyAyMDNUMTQ3IDE2NlQxMjYgMTA2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNzMiIGQ9Ik0yOTUgMzE2UTI5NSAzNTYgMjY4IDM4NVQxOTAgNDE0UTE1NCA0MTQgMTI4IDQwMVE5OCAzODIgOTggMzQ5UTk3IDM0NCA5OCAzMzZUMTE0IDMxMlQxNTcgMjg3UTE3NSAyODIgMjAxIDI3OFQyNDUgMjY5VDI3NyAyNTZRMjk0IDI0OCAzMTAgMjM2VDM0MiAxOTVUMzU5IDEzM1EzNTkgNzEgMzIxIDMxVDE5OCAtMTBIMTkwUTEzOCAtMTAgOTQgMjZMODYgMTlMNzcgMTBRNzEgNCA2NSAtMUw1NCAtMTFINDZINDJRMzkgLTExIDMzIC01Vjc0VjEzMlEzMyAxNTMgMzUgMTU3VDQ1IDE2Mkg1NFE2NiAxNjIgNzAgMTU4VDc1IDE0NlQ4MiAxMTlUMTAxIDc3UTEzNiAyNiAxOTggMjZRMjk1IDI2IDI5NSAxMDRRMjk1IDEzMyAyNzcgMTUxUTI1NyAxNzUgMTk0IDE4N1QxMTEgMjEwUTc1IDIyNyA1NCAyNTZUMzMgMzE4UTMzIDM1NyA1MCAzODRUOTMgNDI0VDE0MyA0NDJUMTg3IDQ0N0gxOThRMjM4IDQ0NyAyNjggNDMyTDI4MyA0MjRMMjkyIDQzMVEzMDIgNDQwIDMxNCA0NDhIMzIySDMyNlEzMjkgNDQ4IDMzNSA0NDJWMzEwTDMyOSAzMDRIMzAxUTI5NSAzMTAgMjk1IDMxNloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpTWjEtMjgiIGQ9Ik0xNTIgMjUxUTE1MiA2NDYgMzg4IDg1MEg0MTZRNDIyIDg0NCA0MjIgODQxUTQyMiA4MzcgNDAzIDgxNlQzNTcgNzUzVDMwMiA2NDlUMjU1IDQ4MlQyMzYgMjUwUTIzNiAxMjQgMjU1IDE5VDMwMSAtMTQ3VDM1NiAtMjUxVDQwMyAtMzE1VDQyMiAtMzQwUTQyMiAtMzQzIDQxNiAtMzQ5SDM4OFEzNTkgLTMyNSAzMzIgLTI5NlQyNzEgLTIxM1QyMTIgLTk3VDE3MCA1NlQxNTIgMjUxWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSlNaMS0yOSIgZD0iTTMwNSAyNTFRMzA1IC0xNDUgNjkgLTM0OUg1NlE0MyAtMzQ5IDM5IC0zNDdUMzUgLTMzOFEzNyAtMzMzIDYwIC0zMDdUMTA4IC0yMzlUMTYwIC0xMzZUMjA0IDI3VDIyMSAyNTBUMjA0IDQ3M1QxNjAgNjM2VDEwOCA3NDBUNjAgODA3VDM1IDgzOVEzNSA4NTAgNTAgODUwSDU2SDY5UTE5NyA3NDMgMjU2IDU2NlEzMDUgNDI1IDMwNSAyNTFaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFJTi0zMiIgZD0iTTEwOSA0MjlRODIgNDI5IDY2IDQ0N1Q1MCA0OTFRNTAgNTYyIDEwMyA2MTRUMjM1IDY2NlEzMjYgNjY2IDM4NyA2MTBUNDQ5IDQ2NVE0NDkgNDIyIDQyOSAzODNUMzgxIDMxNVQzMDEgMjQxUTI2NSAyMTAgMjAxIDE0OUwxNDIgOTNMMjE4IDkyUTM3NSA5MiAzODUgOTdRMzkyIDk5IDQwOSAxODZWMTg5SDQ0OVYxODZRNDQ4IDE4MyA0MzYgOTVUNDIxIDNWMEg1MFYxOVYzMVE1MCAzOCA1NiA0NlQ4NiA4MVExMTUgMTEzIDEzNiAxMzdRMTQ1IDE0NyAxNzAgMTc0VDIwNCAyMTFUMjMzIDI0NFQyNjEgMjc4VDI4NCAzMDhUMzA1IDM0MFQzMjAgMzY5VDMzMyA0MDFUMzQwIDQzMVQzNDMgNDY0UTM0MyA1MjcgMzA5IDU3M1QyMTIgNjE5UTE3OSA2MTkgMTU0IDYwMlQxMTkgNTY5VDEwOSA1NTBRMTA5IDU0OSAxMTQgNTQ5UTEzMiA1NDkgMTUxIDUzNVQxNzAgNDg5UTE3MCA0NjQgMTU0IDQ0N1QxMDkgNDI5WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tMkIiIGQ9Ik01NiAyMzdUNTYgMjUwVDcwIDI3MEgzNjlWNDIwTDM3MCA1NzBRMzgwIDU4MyAzODkgNTgzUTQwMiA1ODMgNDA5IDU2OFYyNzBINzA3UTcyMiAyNjIgNzIyIDI1MFQ3MDcgMjMwSDQwOVYtNjhRNDAxIC04MiAzOTEgLTgySDM4OUgzODdRMzc1IC04MiAzNjkgLTY4VjIzMEg3MFE1NiAyMzcgNTYgMjUwWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNTYiIGQ9Ik0xMTQgNjIwUTExMyA2MjEgMTEwIDYyNFQxMDcgNjI3VDEwMyA2MzBUOTggNjMyVDkxIDYzNFQ4MCA2MzVUNjcgNjM2VDQ4IDYzN0gxOVY2ODNIMjhRNDYgNjgwIDE1MiA2ODBRMjczIDY4MCAyOTQgNjgzSDMwNVY2MzdIMjg0UTIyMyA2MzQgMjIzIDYyMFEyMjMgNjE4IDMxMyAzNzJUNDA0IDEyNkw0OTAgMzU4UTU3NSA1ODggNTc1IDU5N1E1NzUgNjE2IDU1NCA2MjZUNTA4IDYzN0g1MDNWNjgzSDUxMlE1MjcgNjgwIDYyNyA2ODBRNzE4IDY4MCA3MjQgNjgzSDczMFY2MzdINzIzUTY0OCA2MzcgNjI3IDU5NlE2MjcgNTk1IDUxNSAyOTFUNDAxIC0xNFEzOTYgLTIyIDM4MiAtMjJIMzc0SDM2N1EzNTMgLTIyIDM0OCAtMTRRMzQ2IC0xMiAyMzEgMzAzUTExNCA2MTcgMTE0IDYyMFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpNQUlOLTcyIiBkPSJNMzYgNDZINTBRODkgNDYgOTcgNjBWNjhROTcgNzcgOTcgOTFUOTggMTIyVDk4IDE2MVQ5OCAyMDNROTggMjM0IDk4IDI2OVQ5OCAzMjhMOTcgMzUxUTk0IDM3MCA4MyAzNzZUMzggMzg1SDIwVjQwOFEyMCA0MzEgMjIgNDMxTDMyIDQzMlE0MiA0MzMgNjAgNDM0VDk2IDQzNlExMTIgNDM3IDEzMSA0MzhUMTYwIDQ0MVQxNzEgNDQySDE3NFYzNzNRMjEzIDQ0MSAyNzEgNDQxSDI3N1EzMjIgNDQxIDM0MyA0MTlUMzY0IDM3M1EzNjQgMzUyIDM1MSAzMzdUMzEzIDMyMlEyODggMzIyIDI3NiAzMzhUMjYzIDM3MlEyNjMgMzgxIDI2NSAzODhUMjcwIDQwMFQyNzMgNDA1UTI3MSA0MDcgMjUwIDQwMVEyMzQgMzkzIDIyNiAzODZRMTc5IDM0MSAxNzkgMjA3VjE1NFExNzkgMTQxIDE3OSAxMjdUMTc5IDEwMVQxODAgODFUMTgwIDY2VjYxUTE4MSA1OSAxODMgNTdUMTg4IDU0VDE5MyA1MVQyMDAgNDlUMjA3IDQ4VDIxNiA0N1QyMjUgNDdUMjM1IDQ2VDI0NSA0NkgyNzZWMEgyNjdRMjQ5IDMgMTQwIDNRMzcgMyAyOCAwSDIwVjQ2SDM2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tMzEiIGQ9Ik0yMTMgNTc4TDIwMCA1NzNRMTg2IDU2OCAxNjAgNTYzVDEwMiA1NTZIODNWNjAySDEwMlExNDkgNjA0IDE4OSA2MTdUMjQ1IDY0MVQyNzMgNjYzUTI3NSA2NjYgMjg1IDY2NlEyOTQgNjY2IDMwMiA2NjBWMzYxTDMwMyA2MVEzMTAgNTQgMzE1IDUyVDMzOSA0OFQ0MDEgNDZINDI3VjBINDE2UTM5NSAzIDI1NyAzUTEyMSAzIDEwMCAwSDg4VjQ2SDExNFExMzYgNDYgMTUyIDQ2VDE3NyA0N1QxOTMgNTBUMjAxIDUyVDIwNyA1N1QyMTMgNjFWNTc4WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNUIiIGQ9Ik0xMTggLTI1MFY3NTBIMjU1VjcxMEgxNThWLTIxMEgyNTVWLTI1MEgxMThaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFUSEktNzIiIGQ9Ik0yMSAyODdRMjIgMjkwIDIzIDI5NVQyOCAzMTdUMzggMzQ4VDUzIDM4MVQ3MyA0MTFUOTkgNDMzVDEzMiA0NDJRMTYxIDQ0MiAxODMgNDMwVDIxNCA0MDhUMjI1IDM4OFEyMjcgMzgyIDIyOCAzODJUMjM2IDM4OVEyODQgNDQxIDM0NyA0NDFIMzUwUTM5OCA0NDEgNDIyIDQwMFE0MzAgMzgxIDQzMCAzNjNRNDMwIDMzMyA0MTcgMzE1VDM5MSAyOTJUMzY2IDI4OFEzNDYgMjg4IDMzNCAyOTlUMzIyIDMyOFEzMjIgMzc2IDM3OCAzOTJRMzU2IDQwNSAzNDIgNDA1UTI4NiA0MDUgMjM5IDMzMVEyMjkgMzE1IDIyNCAyOThUMTkwIDE2NVExNTYgMjUgMTUxIDE2UTEzOCAtMTEgMTA4IC0xMVE5NSAtMTEgODcgLTVUNzYgN1Q3NCAxN1E3NCAzMCAxMTQgMTg5VDE1NCAzNjZRMTU0IDQwNSAxMjggNDA1UTEwNyA0MDUgOTIgMzc3VDY4IDMxNlQ1NyAyODBRNTUgMjc4IDQxIDI3OEgyN1EyMSAyODQgMjEgMjg3WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTU0IiBkPSJNNDAgNDM3UTIxIDQzNyAyMSA0NDVRMjEgNDUwIDM3IDUwMVQ3MSA2MDJMODggNjUxUTkzIDY2OSAxMDEgNjc3SDU2OUg2NTlRNjkxIDY3NyA2OTcgNjc2VDcwNCA2NjdRNzA0IDY2MSA2ODcgNTUzVDY2OCA0NDRRNjY4IDQzNyA2NDkgNDM3UTY0MCA0MzcgNjM3IDQzN1Q2MzEgNDQyTDYyOSA0NDVRNjI5IDQ1MSA2MzUgNDkwVDY0MSA1NTFRNjQxIDU4NiA2MjggNjA0VDU3MyA2MjlRNTY4IDYzMCA1MTUgNjMxUTQ2OSA2MzEgNDU3IDYzMFQ0MzkgNjIyUTQzOCA2MjEgMzY4IDM0M1QyOTggNjBRMjk4IDQ4IDM4NiA0NlE0MTggNDYgNDI3IDQ1VDQzNiAzNlE0MzYgMzEgNDMzIDIyUTQyOSA0IDQyNCAxTDQyMiAwUTQxOSAwIDQxNSAwUTQxMCAwIDM2MyAxVDIyOCAyUTk5IDIgNjQgMEg0OVE0MyA2IDQzIDlUNDUgMjdRNDkgNDAgNTUgNDZIODNIOTRRMTc0IDQ2IDE4OSA1NVExOTAgNTYgMTkxIDU2UTE5NiA1OSAyMDEgNzZUMjQxIDIzM1EyNTggMzAxIDI2OSAzNDRRMzM5IDYxOSAzMzkgNjI1UTMzOSA2MzAgMzEwIDYzMEgyNzlRMjEyIDYzMCAxOTEgNjI0UTE0NiA2MTQgMTIxIDU4M1Q2NyA0NjdRNjAgNDQ1IDU3IDQ0MVQ0MyA0MzdINDBaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLU1KTUFUSEktNTAiIGQ9Ik0yODcgNjI4UTI4NyA2MzUgMjMwIDYzN1EyMDYgNjM3IDE5OSA2MzhUMTkyIDY0OFExOTIgNjQ5IDE5NCA2NTlRMjAwIDY3OSAyMDMgNjgxVDM5NyA2ODNRNTg3IDY4MiA2MDAgNjgwUTY2NCA2NjkgNzA3IDYzMVQ3NTEgNTMwUTc1MSA0NTMgNjg1IDM4OVE2MTYgMzIxIDUwNyAzMDNRNTAwIDMwMiA0MDIgMzAxSDMwN0wyNzcgMTgyUTI0NyA2NiAyNDcgNTlRMjQ3IDU1IDI0OCA1NFQyNTUgNTBUMjcyIDQ4VDMwNSA0NkgzMzZRMzQyIDM3IDM0MiAzNVEzNDIgMTkgMzM1IDVRMzMwIDAgMzE5IDBRMzE2IDAgMjgyIDFUMTgyIDJRMTIwIDIgODcgMlQ1MSAxUTMzIDEgMzMgMTFRMzMgMTMgMzYgMjVRNDAgNDEgNDQgNDNUNjcgNDZROTQgNDYgMTI3IDQ5UTE0MSA1MiAxNDYgNjFRMTQ5IDY1IDIxOCAzMzlUMjg3IDYyOFpNNjQ1IDU1NFE2NDUgNTY3IDY0MyA1NzVUNjM0IDU5N1Q2MDkgNjE5VDU2MCA2MzVRNTUzIDYzNiA0ODAgNjM3UTQ2MyA2MzcgNDQ1IDYzN1Q0MTYgNjM2VDQwNCA2MzZRMzkxIDYzNSAzODYgNjI3UTM4NCA2MjEgMzY3IDU1MFQzMzIgNDEyVDMxNCAzNDRRMzE0IDM0MiAzOTUgMzQySDQwN0g0MzBRNTQyIDM0MiA1OTAgMzkyUTYxNyA0MTkgNjMxIDQ3MVQ2NDUgNTU0WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BVEhJLTUyIiBkPSJNMjMwIDYzN1EyMDMgNjM3IDE5OCA2MzhUMTkzIDY0OVExOTMgNjc2IDIwNCA2ODJRMjA2IDY4MyAzNzggNjgzUTU1MCA2ODIgNTY0IDY4MFE2MjAgNjcyIDY1OCA2NTJUNzEyIDYwNlQ3MzMgNTYzVDczOSA1MjlRNzM5IDQ4NCA3MTAgNDQ1VDY0MyAzODVUNTc2IDM1MVQ1MzggMzM4TDU0NSAzMzNRNjEyIDI5NSA2MTIgMjIzUTYxMiAyMTIgNjA3IDE2MlQ2MDIgODBWNzFRNjAyIDUzIDYwMyA0M1Q2MTQgMjVUNjQwIDE2UTY2OCAxNiA2ODYgMzhUNzEyIDg1UTcxNyA5OSA3MjAgMTAyVDczNSAxMDVRNzU1IDEwNSA3NTUgOTNRNzU1IDc1IDczMSAzNlE2OTMgLTIxIDY0MSAtMjFINjMyUTU3MSAtMjEgNTMxIDRUNDg3IDgyUTQ4NyAxMDkgNTAyIDE2NlQ1MTcgMjM5UTUxNyAyOTAgNDc0IDMxM1E0NTkgMzIwIDQ0OSAzMjFUMzc4IDMyM0gzMDlMMjc3IDE5M1EyNDQgNjEgMjQ0IDU5UTI0NCA1NSAyNDUgNTRUMjUyIDUwVDI2OSA0OFQzMDIgNDZIMzMzUTMzOSAzOCAzMzkgMzdUMzM2IDE5UTMzMiA2IDMyNiAwSDMxMVEyNzUgMiAxODAgMlExNDYgMiAxMTcgMlQ3MSAyVDUwIDFRMzMgMSAzMyAxMFEzMyAxMiAzNiAyNFE0MSA0MyA0NiA0NVE1MCA0NiA2MSA0Nkg2N1E5NCA0NiAxMjcgNDlRMTQxIDUyIDE0NiA2MVExNDkgNjUgMjE4IDMzOVQyODcgNjI4UTI4NyA2MzUgMjMwIDYzN1pNNjMwIDU1NFE2MzAgNTg2IDYwOSA2MDhUNTIzIDYzNlE1MjEgNjM2IDUwMCA2MzZUNDYyIDYzN0g0NDBRMzkzIDYzNyAzODYgNjI3UTM4NSA2MjQgMzUyIDQ5NFQzMTkgMzYxUTMxOSAzNjAgMzg4IDM2MFE0NjYgMzYxIDQ5MiAzNjdRNTU2IDM3NyA1OTIgNDI2UTYwOCA0NDkgNjE5IDQ4NlQ2MzAgNTU0WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1NSk1BSU4tNUQiIGQ9Ik0yMiA3MTBWNzUwSDE1OVYtMjUwSDIyVi0yMTBIMTE5VjcxMEgyMloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpTWjQtNUIiIGQ9Ik0yNjkgLTEyNDlWMTc1MEg1NzdWMTY3N0gzNDJWLTExNzZINTc3Vi0xMjQ5SDI2OVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtTUpTWjQtNUQiIGQ9Ik01IDE2NzdWMTc1MEgzMTNWLTEyNDlINVYtMTE3NkgyNDBWMTY3N0g1WiI+PC9wYXRoPgo8L2RlZnM+CjxnIHN0cm9rZT0iY3VycmVudENvbG9yIiBmaWxsPSJjdXJyZW50Q29sb3IiIHN0cm9rZS13aWR0aD0iMCIgdHJhbnNmb3JtPSJtYXRyaXgoMSAwIDAgLTEgMCAwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNEQiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTUzIiB4PSI5MTciIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTQ1IiB4PSIxNDc0IiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTQ2IiB4PSIzMDQ4IiB5PSI2MTIiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNkUiIHg9IjMwNDgiIHk9Ii0zNTAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgyOTUyLDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIzODkiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSI4NTkiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tM0QiIHg9IjQ0NzgiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg1NTM0LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KU1oxLTI4Ij48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNDU4LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi00MiI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNjkiIHg9IjcwOCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNjEiIHg9Ijk4NyIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNzMiIHg9IjE0ODciIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNDYiIHg9IjI2NjEiIHk9IjU4MSI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS02RSIgeD0iMjY2MSIgeT0iLTM1MCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDI2NzgsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI4IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzMiIHg9IjM4OSIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMjkiIHg9Ijg1OSIgeT0iMCI+PC91c2U+CjwvZz4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpTWjEtMjkiIHg9IjQzODUiIHk9Ii0xIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMzIiIHg9IjY4NTAiIHk9Ijg3NiI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yQiIgeD0iMTEwNTQiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxMjA1NSwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNTYiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTYxIiB4PSI3NTAiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTcyIiB4PSIxMjUxIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTQ2IiB4PSIyMzI0IiB5PSI1ODEiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNkUiIHg9IjIzMjQiIHk9Ii0zNTAiPjwvdXNlPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDE0NDk1LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0yOCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIzODkiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSI4NTkiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tM0QiIHg9IjE2MDIyIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMTY4MDAsMCkiPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgzOTcsMCkiPgo8cmVjdCBzdHJva2U9Im5vbmUiIHdpZHRoPSI3MjAiIGhlaWdodD0iNjAiIHg9IjAiIHk9IjIyMCI+PC9yZWN0PgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTMxIiB4PSIxMTAiIHk9IjY3NiI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTZFIiB4PSI2MCIgeT0iLTY4NiI+PC91c2U+CjwvZz4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxODAzOCwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSlNaNC01QiI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDU4MywwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tNTYiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTYxIiB4PSI3NTAiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTcyIiB4PSIxMjUxIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMTgxMCwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMjgiIHg9IjAiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgzODksMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS03MiIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS01NCIgeD0iNjM4IiB5PSItMjEzIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSIxNDM5IiB5PSIwIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTJCIiB4PSIzODYxIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNDYzOSwwKSI+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDM0MiwwKSI+CjxyZWN0IHN0cm9rZT0ibm9uZSIgd2lkdGg9IjEzNjAiIGhlaWdodD0iNjAiIHg9IjAiIHk9IjIyMCI+PC9yZWN0Pgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxNDMsNjc3KSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTUwIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSI5MDgiIHk9Ii0yMTMiPjwvdXNlPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDYwLC03MDQpIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTAiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTQiIHg9IjkwOCIgeT0iLTIxMyI+PC91c2U+CjwvZz4KPC9nPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDY0NjIsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTU2Ij48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi02MSIgeD0iNzUwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi03MiIgeD0iMTI1MSIgeT0iMCI+PC91c2U+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoODI3MiwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSk1BSU4tMjgiIHg9IjAiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgzODksMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS03MiIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQVRISS03MyIgeD0iNjM4IiB5PSItMjEzIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTI5IiB4PSIxMjcyIiB5PSIwIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQUlOLTJCIiB4PSIxMDE1NyIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDEwOTM1LDApIj4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMzQyLDApIj4KPHJlY3Qgc3Ryb2tlPSJub25lIiB3aWR0aD0iMTM2MCIgaGVpZ2h0PSI2MCIgeD0iMCIgeT0iMjIwIj48L3JlY3Q+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDE0Myw2NzcpIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTAiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNzMiIHg9IjkwOCIgeT0iLTIxMyI+PC91c2U+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNjAsLTgzNykiPgogPHVzZSB4bGluazpocmVmPSIjRTEtTUpNQVRISS01MCIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtTUpNQUlOLTMyIiB4PSIxMTA5IiB5PSI0ODgiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTQiIHg9IjkwOCIgeT0iLTQ0NiI+PC91c2U+CjwvZz4KPC9nPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDEyNzU4LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLU1KTUFUSEktNTIiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLU1KTUFJTi0zMiIgeD0iMTA3NCIgeT0iNDg4Ij48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1NSk1BVEhJLTczIiB4PSIxMDc0IiB5PSItMjEyIj48L3VzZT4KPC9nPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1NSlNaNC01RCIgeD0iMTQ1NTUiIHk9Ii0xIj48L3VzZT4KPC9nPgo8L2c+Cjwvc3ZnPg==)

定理7 一次试验后每次访问MC方法的方差受到以下限制: